En la era digital actual, la promesa de la privacidad y la seguridad en nuestras comunicaciones es un pilar fundamental sobre el que construimos gran parte de nuestra vida en línea. Nos hemos acostumbrado a confiar en sistemas de cifrado robustos que, en teoría, protegen nuestros mensajes, nuestras llamadas y, cada vez más, nuestras interacciones con inteligencias artificiales conversacionales. La idea de que una conversación cifrada es una conversación privada se ha arraigado profundamente en nuestra conciencia colectiva, ofreciéndonos una sensación de seguridad ante miradas indiscretas. Sin embargo, ¿qué sucede cuando esta confianza se ve socavada no por una falla en el cifrado en sí, sino por una debilidad intrínseca en el diseño de la herramienta con la que interactuamos? Imagina que, a pesar de que tus palabras están selladas y protegidas, existe una forma de que terceros conozcan el tema de lo que hablas, comprometiendo tu confidencialidad de una manera que ni siquiera el más sofisticado algoritmo de cifrado podría prever. Esta es la inquietante realidad que surge cuando un fallo en el diseño de un chatbot permite la deducción de los temas de conversación, incluso si el contenido exacto permanece impenetrable. Es un recordatorio crudo de que la privacidad es una cadena con muchos eslabones, y la fortaleza de uno no compensa la debilidad de otro.

La ilusión de la privacidad digital y el cifrado

El cifrado se ha convertido en la piedra angular de la seguridad en internet. Desde las transacciones bancarias hasta los mensajes personales, la encriptación de extremo a extremo (E2EE, por sus siglas en inglés) es promocionada como la barrera impenetrable que garantiza que solo el emisor y el receptor puedan leer el contenido de una comunicación. Y con razón. La criptografía moderna es, en su esencia, una maravilla matemática que convierte la información legible en un galimatías indescifrable sin la clave correcta. Esto ha llevado a una expectativa generalizada de privacidad cuando usamos aplicaciones y servicios que anuncian esta característica, como WhatsApp, Signal o incluso nuestras conversaciones con asistentes de voz y chatbots. Confiamos en que, al hablar con un chatbot, nuestras consultas sobre salud, finanzas, planes personales o cualquier otro tema sensible permanecerán estrictamente entre nosotros y la IA, protegidas por una capa de seguridad inexpugnable.

Sin embargo, la confianza ciega en la tecnología puede ser peligrosa. La realidad es que el ecosistema digital es increíblemente complejo, con múltiples capas de interacción, procesamiento y almacenamiento de datos. Un sistema puede ser criptográficamente seguro, pero aún así tener puntos débiles en su implementación o diseño que expongan información sensible. Es aquí donde la complejidad se convierte en una aliada de las vulnerabilidades. No es mi intención sembrar pánico, sino fomentar una conciencia crítica sobre cómo se construye y se mantiene la privacidad en el mundo digital. A menudo, las empresas se centran en el aspecto más visible de la seguridad —el cifrado del contenido—, descuidando otros vectores de ataque o, en este caso, de fuga de información. Este escenario resalta que la seguridad no es solo un interruptor de encendido/apagado, sino un conjunto intrincado de consideraciones que deben abordarse en cada etapa del ciclo de vida del producto. Un fallo en el diseño de un chatbot que permite deducir el tema de una conversación cifrada es un ejemplo paradigmático de cómo las vulnerabilidades pueden esconderse en los lugares más inesperados, incluso en aquellos que se consideran fortalezas.

El intrincado fallo de diseño: ¿cómo ocurre la filtración?

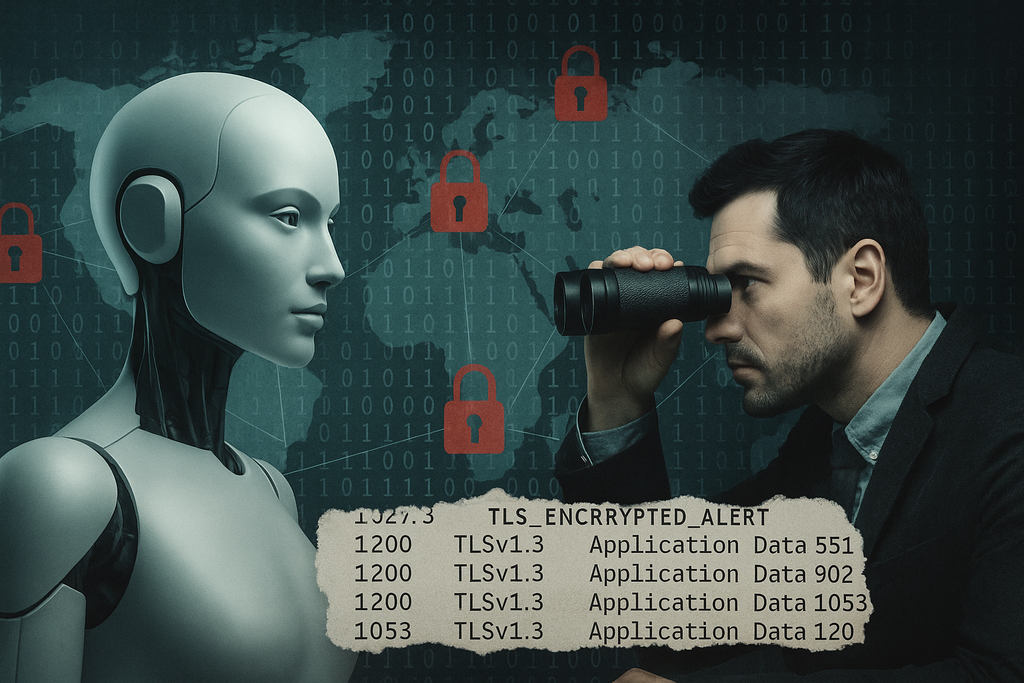

La pregunta clave aquí es: si la conversación está cifrada, ¿cómo es posible que se deduzca el tema? La respuesta no reside en romper el cifrado, sino en explotar información que queda expuesta alrededor de los datos cifrados, es decir, metadatos, patrones de interacción o características indirectas del sistema. Esto se conoce como ataques de canal lateral o inferencia de atributos.

¿Qué información se filtra y cómo?

Imagina el cifrado como un sobre sellado. El contenido es ilegible, pero la forma del sobre, su tamaño, el peso, el franqueo o la dirección del remitente y el destinatario (metadatos) pueden dar pistas significativas. En el contexto de un chatbot, esta "información periférica" puede manifestarse de diversas maneras:

- Análisis de latencia y patrones de envío: Ciertos tipos de consultas o la longitud esperada de las respuestas pueden tener un impacto predecible en la latencia de la red o en la secuencia de interacción. Por ejemplo, una consulta compleja sobre finanzas personales podría implicar un tiempo de procesamiento más largo para el chatbot, o una serie de preguntas y respuestas más estructuradas, lo cual podría ser detectable. Si un atacante monitorea el tráfico de red, incluso si está cifrado, los patrones de tiempo y tamaño de los paquetes pueden correlacionarse con tipos específicos de conversaciones.

- Tamaño de los mensajes (incluso cifrados): Aunque el contenido esté cifrado, el tamaño del mensaje cifrado suele ser proporcional al tamaño del mensaje original (o a una pequeña porción de él). Si un usuario está discutiendo un tema que tiende a generar respuestas largas del chatbot (por ejemplo, extractos de políticas o descripciones detalladas) o, por el contrario, respuestas muy cortas (confirmaciones simples), el análisis del tamaño de los paquetes de datos cifrados a lo largo del tiempo podría revelar el tipo de interacción.

- Interacciones con servicios externos (API calls): Muchos chatbots no operan de forma aislada. Para responder a ciertas preguntas, pueden hacer llamadas a APIs de terceros (servicios meteorológicos, bases de datos de conocimiento, sistemas bancarios, etc.). Aunque el contenido de la consulta al chatbot esté cifrado, la acción del chatbot de llamar a una API externa específica (que podría estar menos protegida o ser directamente visible para un atacante con acceso a la red interna del proveedor del chatbot) podría delatar el tema de la conversación. Si el chatbot llama a una API de "saldo bancario", es evidente que se está hablando de finanzas.

- Uso de modelos de lenguaje subyacentes: Los modelos de IA son complejos. Un atacante ingenioso podría, hipotéticamente, intentar "interrogar" o manipular el modelo subyacente que alimenta al chatbot (si tiene algún acceso, incluso limitado o indirecto) para inferir qué tipo de datos o patrones de conversación está procesando. Esto podría ser a través de técnicas de aprendizaje automático que intenten reconstruir o clasificar los temas que el modelo está siendo entrenado o está procesando en tiempo real, incluso si el contenido específico está protegido.

- Análisis de "temperatura" o "estilo" de respuesta del chatbot: Aunque esto es más especulativo, ciertos temas pueden llevar a que el chatbot responda con un "tono" o "estilo" particular (más formal, más informal, más conciso). Si este estilo se refleja en características medibles (por ejemplo, variaciones en la longitud promedio de las palabras, complejidad sintáctica), y estas características no están completamente ofuscadas por el cifrado o por mecanismos de privacidad, podría ser otra pista.

El problema radica en que, incluso si el contenido de tu mensaje está herméticamente sellado, los efectos secundarios o los rastros que deja la interacción con el sistema pueden ser suficientes para inferir información valiosa.

¿Conversaciones cifradas? No son inmunes.

Es crucial entender que el cifrado protege el contenido del mensaje, no el contexto o los metadatos asociados con él. Es como enviar un paquete por correo: sabes que el contenido está seguro dentro de la caja, pero la etiqueta de envío revela quién lo envía, quién lo recibe, cuándo se envió y, posiblemente, por el peso y el tamaño, incluso qué tipo de objeto podría contener. Estos metadatos, aparentemente inocuos, pueden ser increíblemente reveladores.

En el caso de un chatbot, la conversación cifrada significa que nadie puede leer las palabras exactas que teclear o decir. Sin embargo, un fallo en el diseño significa que la forma en que el chatbot procesa, responde o interactúa con otros sistemas puede filtrar datos indirectamente. Los ataques de canal lateral son particularmente insidiosos porque no requieren romper la criptografía subyacente, sino observar los efectos físicos o computacionales del procesamiento de datos cifrados. Pueden ser tan simples como medir el tiempo que tarda un servidor en responder a una solicitud específica o tan complejos como analizar fluctuaciones de energía.

El hecho de que esto pueda ocurrir en conversaciones cifradas es lo que lo hace tan alarmante. La promesa del cifrado es que el contenido es impenetrable. Si podemos inferir el tema de una conversación, estamos un paso más cerca de inferir el contenido, y la barrera de la privacidad se ve comprometida. Es un recordatorio de que la seguridad de un sistema no es la suma de sus componentes individuales, sino la de su eslabón más débil, que a menudo reside en la implementación y el diseño, no en la teoría criptográfica.

Consecuencias y riesgos para los usuarios

La posibilidad de que se deduzcan los temas de conversación, incluso en interacciones cifradas, tiene ramificaciones serias para la privacidad y la seguridad de los usuarios. Las implicaciones van más allá de una simple molestia, adentrándose en el ámbito de la manipulación, la discriminación y la vigilancia.

Pérdida de confidencialidad y perfilado

La consecuencia más inmediata es la pérdida de confidencialidad. Si los temas de conversación pueden ser identificados, se puede construir un perfil sorprendentemente detallado de un usuario sin necesidad de conocer las palabras exactas. Por ejemplo, si se detecta que un usuario habla repetidamente sobre síntomas de una enfermedad específica, finanzas personales, problemas legales o preferencias políticas, se está creando un "perfil de interés" que es altamente sensible.

Este perfilado puede tener múltiples usos:

- Publicidad dirigida y manipulación: Las empresas pueden utilizar esta información para ofrecer anuncios ultra-dirigidos, aprovechando las vulnerabilidades emocionales o las necesidades detectadas. Esto va más allá de un marketing inteligente; puede cruzar la línea hacia la manipulación, presentando ofertas de productos o servicios en momentos de vulnerabilidad del usuario.

- Discriminación: La información sobre la salud, la situación financiera o la ideología política puede ser utilizada para discriminar. Por ejemplo, aseguradoras que ajustan primas, instituciones financieras que niegan créditos o empleadores que toman decisiones basadas en inferencias sobre la vida privada de una persona.

- Ingeniería social: Los delincuentes podrían usar esta información para lanzar ataques de ingeniería social más sofisticados, personalizando mensajes de phishing o estafas para que parezcan más creíbles y relevantes para el usuario, explotando así los temas de conversación identificados.

Es mi firme opinión que este tipo de filtración erosiona la confianza en la tecnología de una forma insidiosa. Los usuarios creen que están protegidos, y cuando esa protección resulta ser incompleta debido a un fallo en el diseño, no solo se violan sus derechos a la privacidad, sino que se socava la base misma de la interacción digital segura.

Implicaciones para la seguridad y la libertad de expresión

Las repercusiones de este tipo de fallos no se limitan al ámbito comercial. Hay implicaciones significativas para la seguridad personal y la libertad de expresión, especialmente en contextos donde la privacidad es crucial.

- Vigilancia y represión: En regímenes autoritarios o para actividades sensibles (periodismo de investigación, activismo político, protección de fuentes), la capacidad de deducir temas de conversación podría ser una herramienta de vigilancia poderosa. No es necesario conocer el contenido exacto si se puede identificar que una persona está hablando de "protestas", "política", "disidencia" o "derechos humanos". Esto podría llevar a la represión de la libertad de expresión y la disidencia.

- Extorsión y chantaje: La información sobre temas sensibles (salud mental, relaciones, finanzas ilícitas, etc.) podría ser utilizada para extorsionar a individuos, forzándolos a realizar acciones contra su voluntad bajo amenaza de exponer su "perfil de intereses" o los temas que han discutido en privado.

- Impacto en temas delicados: En campos como la telemedicina o el asesoramiento legal en línea, donde los chatbots y las IA conversacionales están ganando terreno, la confidencialidad es primordial. Si los temas de conversación pueden ser inferidos, se crea una barrera de desconfianza que impide a los usuarios buscar ayuda o consejo en estos canales, limitando el acceso a servicios importantes.

La gravedad de esta situación radica en cómo estos fallos, aparentemente técnicos y sutiles, tienen consecuencias profundas en la vida real de las personas, afectando su seguridad, su autonomía y su capacidad para interactuar libremente en el espacio digital. La privacidad no es un lujo; es un derecho fundamental que sostiene muchos otros derechos y libertades.

¿Quién es responsable y qué medidas se pueden tomar?

Identificar la raíz del problema y asignar responsabilidades es fundamental para abordar estos fallos de diseño y restaurar la confianza del usuario. La solución requiere un enfoque multifacético que involucre a desarrolladores, empresas, reguladores y, por supuesto, a los propios usuarios.

Responsabilidad de los desarrolladores y empresas

Las empresas que diseñan, desarrollan y despliegan chatbots tienen una responsabilidad primordial en garantizar la privacidad y seguridad de sus usuarios. Esto implica ir más allá del mero cumplimiento normativo y adoptar una postura proactiva.

- "Diseño pensando en la privacidad" (Privacy by Design): Este es un principio fundamental que sugiere que la privacidad debe integrarse en el diseño de sistemas y prácticas desde el inicio, no como un añadido posterior. Esto significa anticipar posibles fallas de inferencia de metadatos y diseñar mecanismos para mitigarlas. Un buen recurso para entender esto puede encontrarse en la web de la Oficina del Comisionado de Información de Canadá (Privacy by Design Principles).

- Auditorías de seguridad exhaustivas: Las empresas deben realizar auditorías de seguridad periódicas y rigurosas, no solo para buscar vulnerabilidades obvias, sino también para identificar posibles canales laterales o fuentes de fuga de metadatos. Esto a menudo requiere la participación de expertos en seguridad independientes para obtener una perspectiva objetiva.

- Transparencia: Las empresas deben ser transparentes con sus usuarios sobre cómo se procesan sus datos, qué información se recopila (incluso metadatos), y con quién se comparte. Las políticas de privacidad deben ser claras, concisas y fáciles de entender, no documentos legales opacos. La Unión Europea, a través del GDPR, ha avanzado mucho en esta materia (GDPR Official Site).

- Mecanismos de anonimización y privacidad diferencial: Explorar e implementar técnicas avanzadas de anonimización y privacidad diferencial puede ayudar a proteger los patrones de datos y los metadatos. La privacidad diferencial, por ejemplo, añade "ruido" matemático a los datos para que no se puedan identificar patrones individuales sin afectar la utilidad general de los datos agregados.

Recomendaciones para los usuarios

Aunque gran parte de la responsabilidad recae en los desarrolladores, los usuarios también desempeñan un papel crucial en la protección de su propia privacidad.

- Ser conscientes de la información que se comparte: Antes de interactuar con un chatbot, especialmente si se trata de temas sensibles, detente un momento a considerar si la información que vas a compartir es absolutamente necesaria y si confías en el proveedor del servicio.

- Leer las políticas de privacidad (con sentido crítico): Aunque a menudo son densas, intentar comprender los puntos clave de las políticas de privacidad puede darte una idea de cómo se tratarán tus datos. Presta especial atención a las secciones sobre "cómo usamos sus datos" y "con quién compartimos su información".

- Uso de chatbots con precaución para temas sensibles: Para conversaciones sobre salud, finanzas o asuntos legales, es preferible utilizar canales de comunicación que ofrezcan las máximas garantías de privacidad y confidencialidad, o consultar a profesionales humanos cuando sea posible.

- Buscar alternativas de código abierto o soluciones con mayor transparencia: En algunos casos, las alternativas de código abierto pueden ofrecer mayor transparencia, ya que el código puede ser inspeccionado por la comunidad para identificar posibles fallos de diseño. Un ejemplo es el proyecto Signal para mensajería, que a menudo se considera un estándar de oro en privacidad y cifrado (Signal Messenger).

- Mantener el software actualizado: Aunque no evitará un fallo de diseño fundamental, mantener el software y las aplicaciones actualizadas es una buena práctica de seguridad que puede proteger contra otras vulnerabilidades conocidas.

El futuro de la privacidad en la interacción con IA

La proliferación de la inteligencia artificial en nuestra vida diaria, y en particular de los chatbots, plantea un conjunto de desafíos sin precedentes para la privacidad. A medida que estas tecnologías se vuelven más sofisticadas y omnipresentes, la línea entre la conveniencia y la intrusión se difumina.

Los avances en IA traen consigo la promesa de una interacción más natural e intuitiva, pero también la necesidad imperiosa de investigar y desarrollar métodos de privacidad que vayan más allá del cifrado tradicional del contenido. Conceptos como la "privacidad por diseño" y la "privacidad diferencial" necesitan ser el estándar, no la excepción. También hay tecnologías emergentes como el cifrado homomórfico, que permitiría realizar cálculos sobre datos cifrados sin necesidad de descifrarlos, ofreciendo un nuevo paradigma de protección de datos. Un buen punto de pa