En un mundo que ya lucha contra la marea de información errónea y la dificultad de discernir lo real de lo fabricado, la irrupción de Sora de OpenAI representa un salto tecnológico asombroso que promete revolucionar la creación de contenido visual. Esta herramienta de inteligencia artificial, capaz de generar vídeos hiperrealistas a partir de simples descripciones de texto, abre un abanico de posibilidades creativas inimaginables hasta ahora, desde la producción cinematográfica independiente hasta la educación interactiva y el marketing innovador. Sin embargo, su misma capacidad de emular la realidad con una fidelidad inquietante también enciende una señal de alarma monumental: la posibilidad de que se convierta en una herramienta de desinformación masiva y difamación sin precedentes, afectando no solo a figuras públicas sino a cualquier persona cuya imagen pueda ser manipulada con fines maliciosos. ¿Estamos preparados para un futuro donde lo que vemos ya no sea sinónimo de lo que es verdad? La respuesta, lamentablemente, parece ser un rotundo no, y la urgencia de abordar este dilema ético y social es más apremiante que nunca.

El avance tecnológico de Sora y sus implicaciones

Sora, presentada por OpenAI, es una maraviosa demostración de los límites que la inteligencia artificial puede alcanzar en la generación de contenido multimedia. Su capacidad para transformar descripciones de texto en escenas de vídeo complejas, con múltiples personajes, tipos específicos de movimiento y detalles precisos del sujeto y el fondo, es simplemente asombrosa. Los vídeos que puede producir muestran una coherencia visual y una física casi indistinguible de la realidad, superando con creces a las generaciones anteriores de modelos de texto a vídeo. Esto significa que un guionista o un creador de contenido puede conceptualizar una escena y verla cobrar vida en cuestión de minutos, eliminando barreras técnicas y económicas en la producción audiovisual. Pensemos en las pequeñas empresas que ahora podrían crear anuncios de calidad cinematográfica, o en educadores que podrían ilustrar conceptos abstractos con simulaciones hiperrealistas. La democratización de la creación de vídeo de alta calidad es, sin duda, una promesa tentadora de Sora. Para explorar más sobre la tecnología de Sora, puedes visitar la página oficial de OpenAI sobre Sora.

La disrupción creativa y sus sombras

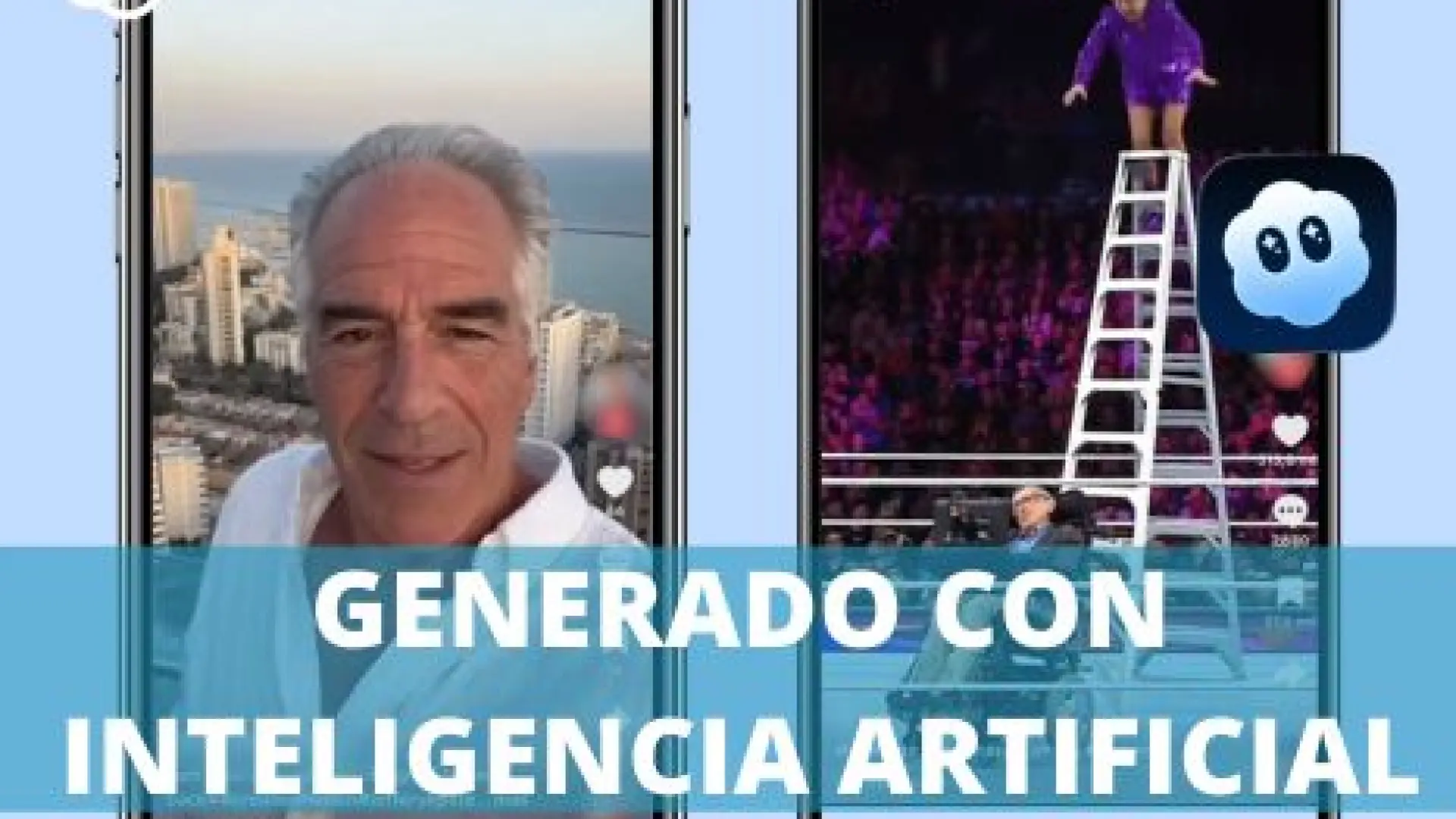

Mientras que el potencial creativo de Sora es inmenso, la misma tecnología que permite crear mundos fantásticos y narrativas envolventes es también la que abre la puerta a la manipulación más sofisticada que hayamos conocido. La facilidad con la que se pueden generar vídeos convincentes de eventos que nunca ocurrieron, o de personas diciendo cosas que jamás pronunciaron, es la principal preocupación. Ya hemos visto los inicios de los 'deepfakes' con vídeos de menor calidad que, no obstante, han causado daño significativo. Sora eleva esta capacidad a un nivel exponencialmente superior, haciendo que la detección visual se vuelva una tarea casi imposible para el ojo humano sin ayuda externa. En este contexto, mi opinión es que, aunque el ingenio detrás de Sora es digno de admiración, la ética de su desarrollo y despliegue debe ser el centro de la conversación, incluso antes de que la herramienta sea ampliamente accesible. La innovación sin una profunda reflexión sobre sus consecuencias es, en última instancia, una receta para el caos.

La amenaza de la desinformación y la difamación en vídeo

La verdadera preocupación con Sora no es su capacidad para crear fantasías, sino su habilidad para imitar la realidad de una manera tan precisa que puede ser indistinguible. Esto nos coloca en una posición increíblemente vulnerable ante la desinformación y, más grave aún, la difamación personal y colectiva.

Daño reputacional sin precedentes para figuras públicas y privadas

Imaginemos un vídeo generado por IA que muestre a un político influyente aceptando un soborno, a un empresario de renombre haciendo declaraciones discriminatorias, o incluso a una celebridad involucrada en un escándalo fabricado. Con la calidad de Sora, estos vídeos podrían parecer absolutamente reales. Las consecuencias para la carrera, la imagen y la vida personal de estas figuras serían devastadoras e instantáneas. La velocidad con la que el contenido se viraliza en redes sociales significa que un vídeo falso puede destruir una reputación antes de que se tenga la oportunidad de refutarlo. Pero el problema no se limita a los personajes públicos. Cualquier persona, en cualquier ámbito de la vida, podría ser objetivo de una campaña de difamación a través de vídeos falsos, lo que representa una amenaza inquietante para la seguridad y la privacidad individual. La mera existencia de tales herramientas podría ser utilizada para extorsión o para silenciar voces críticas, simplemente con la amenaza de crear y difundir contenido difamatorio. Esto subraya la necesidad urgente de considerar medidas de protección legal y tecnológica para salvaguardar la integridad de la identidad digital de las personas.

La erosión de la confianza y la "posverdad"

Si no podemos confiar en lo que vemos, ¿en qué podemos confiar? La proliferación de vídeos hiperrealistas generados por IA amenaza con profundizar la crisis de confianza en las instituciones, los medios de comunicación y, en última instancia, en la propia realidad objetiva. Cuando cualquier evento puede ser desestimado como un "deepfake", incluso si es genuino, entramos en una era de "posverdad" donde los hechos son maleables y las narraciones falsas pueden tener el mismo peso que la verdad. Esta erosión de la confianza es peligrosa para la cohesión social y el funcionamiento de la democracia. El escepticismo generalizado, aunque útil en dosis adecuadas, puede convertirse en cinismo paralizante cuando cada imagen o vídeo se convierte en objeto de sospecha automática. Para entender mejor el impacto de los deepfakes en la sociedad, un artículo interesante es este sobre la amenaza de los deepfakes para la reputación de marca, que también aplica a personas.

El impacto en procesos democráticos y la cohesión social

Los vídeos generados por IA tienen el potencial de influir masivamente en elecciones, referéndums y movimientos sociales. Un vídeo falso de un candidato haciendo una declaración controvertida o actuando de manera inapropiada, difundido estratégicamente antes de unas elecciones, podría cambiar el resultado. Ya hemos sido testigos de cómo las campañas de desinformación han explotado otras vías, y la capacidad de crear "pruebas" visuales irrefutables (aunque falsas) añade una capa de engaño sin precedentes. Esto no solo socava la integridad de los procesos democráticos, sino que también puede exacerbar las divisiones sociales, alimentar el odio y la polarización, al incitar a la gente contra grupos o individuos basándose en narrativas falsas pero visualmente convincentes. Mi preocupación aquí es que el daño no será fácil de revertir, y las cicatrices en el tejido social podrían ser profundas y duraderas.

Desafíos para la detección, la regulación y la responsabilidad

La respuesta a esta amenaza requiere un enfoque multifacético que involucre tecnología, legislación y educación. La escala del problema es tal que ninguna solución aislada será suficiente.

La carrera armamentística de la detección de deepfakes

Actualmente, existen herramientas y algoritmos para detectar deepfakes, pero el ritmo al que avanza la tecnología generativa como Sora es vertiginoso. Es una "carrera armamentística" constante: a medida que los generadores de IA mejoran en la creación de contenido indistinguible de la realidad, los detectores deben volverse aún más sofisticados. Esto implica una inversión constante en investigación y desarrollo para mantener el ritmo, y es probable que siempre estemos un paso por detrás. Además, la detección puede ser compleja y no siempre infalible, dejando un margen para la duda que los desinformadores pueden explotar. Es un ciclo sin fin que requiere atención y recursos continuos. Puedes consultar este artículo sobre los desafíos de la detección de deepfakes para más detalles.

La responsabilidad de los desarrolladores y las plataformas tecnológicas

Los desarrolladores de herramientas como Sora, principalmente OpenAI, tienen una responsabilidad ética y moral ineludible. Deben implementar salvaguardias rigurosas, como marcas de agua invisibles o metadatos que identifiquen el contenido como generado por IA, y establecer políticas de uso estrictas que prohíban la creación de contenido difamatorio o engañoso. Sin embargo, la aplicación de estas políticas es un reto considerable. Las plataformas de redes sociales, por su parte, son los principales vectores de difusión de este tipo de contenido. Deben fortalecer sus mecanismos de moderación, implementar sistemas de verificación de hechos más rápidos y transparentes, y considerar la aplicación de etiquetas claras en el contenido generado por IA, incluso si los usuarios intentan eliminarlas. La colaboración entre desarrolladores, plataformas y organizaciones de verificación de hechos es fundamental. No es suficiente con reaccionar a la difusión de información errónea; es crucial prevenirla y mitigarla proactivamente. Personalmente, creo que las empresas tecnológicas deben priorizar la seguridad y la ética por encima de la velocidad de lanzamiento y la búsqueda de ganancias en estos casos, dada la magnitud del riesgo.

Marcos legales y protección de derechos fundamentales

La legislación actual, en muchos países, no está diseñada para hacer frente a la complejidad de los deepfakes y la desinformación generada por IA. Es necesario adaptar y crear nuevas leyes que criminalicen la creación y difusión maliciosa de contenido falso, que establezcan responsabilidades claras para los creadores de deepfakes y que proporcionen mecanismos efectivos para que las víctimas puedan buscar reparación. Esto incluye la protección del derecho a la propia imagen, el honor y la privacidad, que se ven gravemente amenazados por esta tecnología. El desafío es enorme, ya que la legislación tiende a ser lenta y el problema es global, lo que requiere una cooperación internacional significativa para ser verdaderamente efectiva. La identificación de los culpables, especialmente si utilizan herramientas sofisticadas para anonimizar sus actividades, es otro obstáculo considerable. La Unión Europea ha estado a la vanguardia en la discusión de marcos regulatorios como la Ley de IA, que podría ser un modelo a seguir. Puedes leer más sobre la Ley de IA de la Unión Europea.

El papel crucial de la sociedad civil y la alfabetización digital

Mientras las soluciones tecnológicas y legales se desarrollan, la primera línea de defensa contra la desinformación es la propia ciudadanía.

Fomentar el pensamiento crítico y la verificación de fuentes

En la era de Sora y otras IA generativas, la alfabetización digital y el pensamiento crítico se convierten en habilidades esenciales para la supervivencia informacional. Los individuos deben ser educados para cuestionar lo que ven, a verificar las fuentes, a buscar pruebas contextuales y a reconocer las señales de alerta de contenido manipulado. Esto implica una inversión significativa en educación desde las escuelas hasta programas de formación para adultos. No basta con decirle a la gente que no crea todo lo que ve; hay que proporcionarles las herramientas y el conocimiento para evaluar la credibilidad de la información. Mi esperanza es que esta crisis de confianza fomente una nueva era de escepticismo saludable y una demanda por el periodismo de investigación de alta calidad. Para recursos sobre alfabetización mediática, puedes visitar organizaciones como la Common Sense Media (en inglés, pero con principios aplicables globalmente).

Conclusión: un futuro incierto pero lleno de potencial si se actúa con cautela

Sora de OpenAI es, sin duda, una proeza tecnológica que redefine los límites de la creación de contenido. Su potencial para enriquecer la expresión artística, la educación y la comunicación es innegable y emocionante. Sin embargo, no podemos ignorar la sombra oscura que proyecta sobre la veracidad, la confianza y la integridad de la información en nuestra sociedad. La capacidad de generar vídeos hiperrealistas que pueden usarse para desinformar y difamar a cualquier persona representa una amenaza existencial para la confianza pública y la estabilidad social. Abordar este desafío requiere una respuesta concertada y urgente: los desarrolladores deben priorizar la ética y la seguridad, las plataformas deben asumir una responsabilidad activa en la moderación y la identificación de contenido generado por IA, los legisladores deben actualizar los marcos legales y, fundamentalmente, la sociedad civil debe equiparse con las herramientas del pensamiento crítico y la alfabetización digital. Si logramos navegar este complejo panorama con sabiduría y precaución, el futuro que nos depara la IA podría ser brillante. Pero si fallamos en establecer límites y salvaguardias, corremos el riesgo de entrar en una era donde la verdad es un concepto obsoleto, con consecuencias que aún no podemos prever completamente.