Vivimos en la era de la información, un tiempo de transformaciones sin precedentes impulsadas por la inteligencia artificial. Esta tecnología, capaz de simular procesos de inteligencia humana, ha demostrado un potencial inmenso para el progreso en campos tan diversos como la medicina, la eficiencia energética y la comunicación. Sin embargo, como toda herramienta poderosa, la IA posee un doble filo. Su capacidad para generar contenido de manera autónoma, analizar vastas cantidades de datos y automatizar decisiones, si bien abre puertas a la innovación, también expone a la sociedad a nuevos y complejos riesgos, especialmente en el ámbito de la manipulación. La desinformación, las campañas de influencia y los fraudes no son fenómenos nuevos, pero la IA los potencia a una escala y con una sofisticación nunca antes vistas. La pregunta ya no es si seremos manipulados, sino cómo podemos protegernos eficazmente de las manipulaciones que utilizan la inteligencia artificial para socavar nuestra confianza, nuestras decisiones y, en última instancia, nuestra democracia. Es una tarea que requiere una comprensión profunda de las amenazas, una acción concertada de gobiernos, empresas y ciudadanos, y una vigilancia constante.

El auge de la IA: una espada de doble filo para la sociedad

El desarrollo de la inteligencia artificial ha avanzado a pasos agigantados en la última década. Desde algoritmos de aprendizaje automático que optimizan rutas logísticas hasta redes neuronales generativas que crean imágenes y textos indistinguibles de los producidos por humanos, la IA se ha infiltrado en casi todos los aspectos de nuestra vida. Las ventajas son innegables: optimización de recursos, diagnósticos médicos más precisos, asistentes virtuales que simplifican tareas diarias. Sin embargo, esta misma capacidad de automatización y generación autónoma es la que la convierte en una herramienta formidable para la manipulación. La facilidad con la que se puede crear contenido falso, dirigido y convincente plantea un desafío existencial para la veracidad de la información y la autonomía del pensamiento crítico. Mi opinión es que a menudo nos centramos demasiado en los beneficios y no lo suficiente en los riesgos latentes, creando una brecha en nuestra preparación.

La anatomía de la manipulación con inteligencia artificial

Para protegernos, primero debemos entender las formas en que la IA puede ser instrumentalizada para manipular. No se trata solo de la creación de contenido falso, sino de una gama más amplia de tácticas que explotan las vulnerabilidades cognitivas y sociales humanas.

Desinformación y "deepfakes"

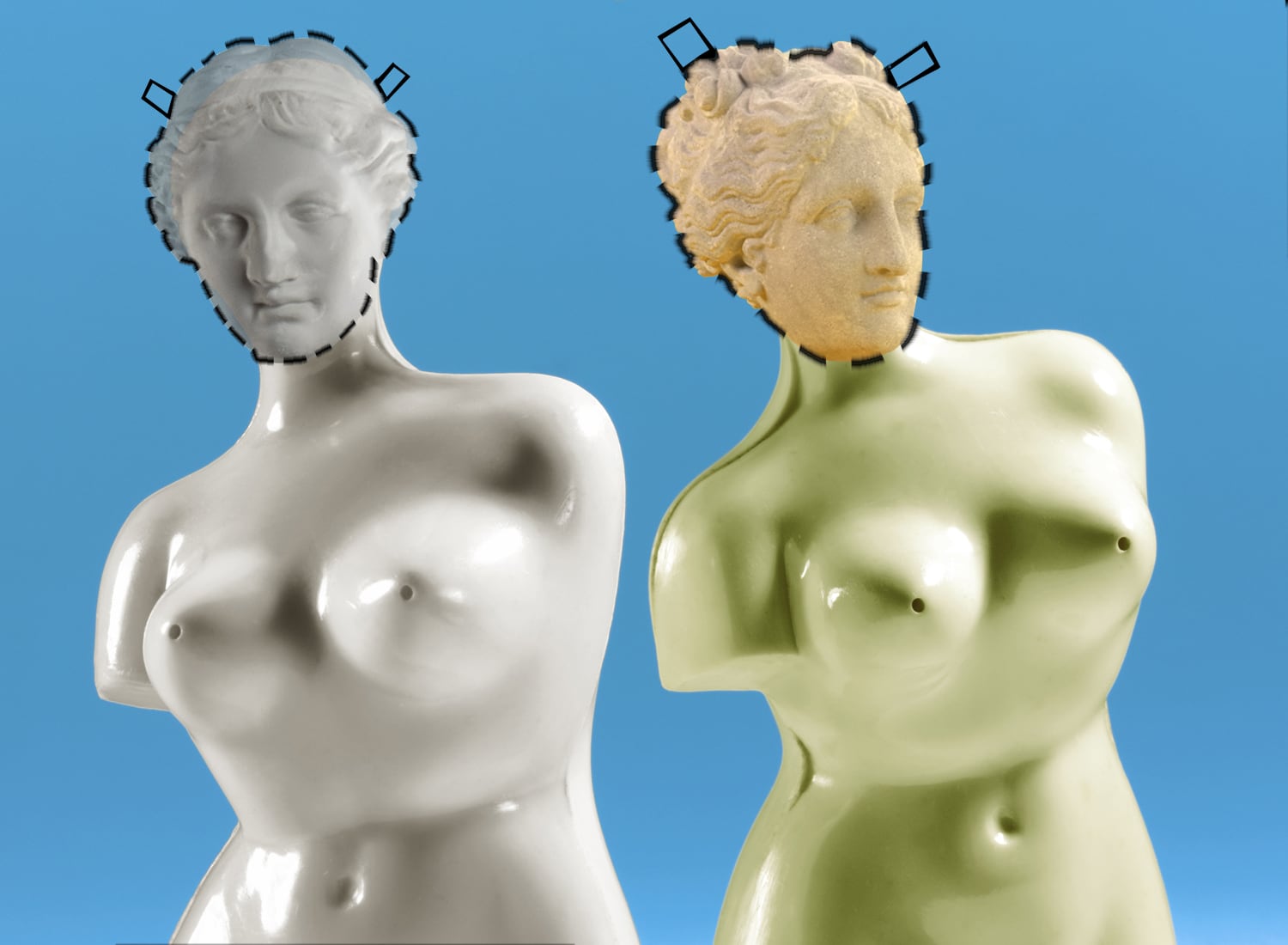

La capacidad de la IA para generar texto, audio e imágenes de alta calidad ha dado origen a una nueva era de desinformación. Los "deepfakes", videos o audios donde se altera el rostro o la voz de una persona para que parezca decir o hacer algo que nunca hizo, son el ejemplo más palpable. Estos pueden utilizarse para difamar a individuos, influir en elecciones o incluso crear incidentes internacionales falsos. Las noticias generadas por IA, aunque gramaticalmente impecables, pueden estar cargadas de sesgos o fabricar narrativas completas. La velocidad de propagación de este tipo de contenido en redes sociales, potenciada también por algoritmos de IA, hace que sea extraordinariamente difícil de contener. La línea entre lo real y lo sintético se difumina, y la confianza en los medios de comunicación y las instituciones se erosiona. Es preocupante observar la creciente sofisticación de estas técnicas; lo que antes se percibía como una curiosidad tecnológica, ahora es una amenaza concreta.

Perfiles predictivos y microsegmentación

La IA es excelente analizando grandes volúmenes de datos. Esta habilidad se utiliza para crear perfiles detallados de individuos, prediciendo sus intereses, vulnerabilidades, creencias políticas y patrones de comportamiento. Con base en estos perfiles, las campañas de manipulación pueden ser microsegmentadas, enviando mensajes específicos a grupos o incluso a personas individuales, diseñados para ser extremadamente persuasivos y explotar sus puntos débiles. Por ejemplo, una noticia diseñada para polarizar a un grupo específico podría ser enviada solo a ellos, reforzando sus sesgos existentes. Esto no es solo publicidad personalizada; es ingeniería social a gran escala, donde la IA identifica las palancas psicológicas más efectivas para cada individuo.

Automatización de ataques y fraudes

La IA también se emplea para automatizar ataques cibernéticos y fraudes. Los "bots" controlados por IA pueden generar miles de correos electrónicos de phishing personalizados, imitando el estilo de comunicación de una persona o institución para aumentar su credibilidad. Pueden simular interacciones humanas en redes sociales para propagar desinformación o amplificar mensajes manipuladores. Incluso existen sistemas de IA capaces de imitar voces en tiempo real para realizar estafas telefónicas, haciendo creer a la víctima que está hablando con un familiar o un directivo de su empresa. La escala y la velocidad que la IA aporta a estos ataques los hacen extremadamente peligrosos y difíciles de detectar manualmente.

Estrategias para blindarse contra la manipulación

La protección contra la manipulación con IA es un esfuerzo multifacético que requiere la participación de todos los sectores de la sociedad. No hay una solución única, sino un conjunto de medidas complementarias.

Educación y alfabetización digital crítica

La primera línea de defensa es la ciudadanía. Es fundamental que las personas desarrollen una alfabetización digital sólida y un pensamiento crítico agudo. Esto implica aprender a identificar fuentes confiables, reconocer patrones de desinformación, entender cómo funcionan los algoritmos de las redes sociales y ser escépticos ante el contenido que despierta emociones intensas o parece demasiado bueno para ser verdad. Programas educativos desde edades tempranas hasta la formación continua de adultos son esenciales para construir una sociedad más resiliente frente a estas amenazas. Invertir en la capacidad de discernimiento de nuestros ciudadanos es quizás la medida más poderosa y sostenible. Un recurso excelente para empezar a entender estos conceptos es el Instituto Nacional de Ciberseguridad (INCIBE), que ofrece guías y recursos para usuarios y empresas: Visita INCIBE para recursos de ciberseguridad.

Desarrollo tecnológico con ética y seguridad

Las empresas y desarrolladores de IA tienen una responsabilidad crucial. Es imperativo que incorporen principios éticos y de seguridad desde las primeras etapas del diseño y desarrollo de sistemas de IA (security by design, ethics by design). Esto incluye la creación de IA explicable (XAI) que permita entender cómo se toman las decisiones, el desarrollo de herramientas para detectar "deepfakes" y contenido generado artificialmente, y la implementación de mecanismos de verificación de procedencia de la información. La industria debe priorizar la seguridad y la fiabilidad sobre la velocidad de lanzamiento de nuevos productos. Hay una creciente comunidad que aboga por la ética en la IA; el IEEE, por ejemplo, tiene iniciativas significativas al respecto: Explora los principios de ética en IA del IEEE.

Marco regulatorio y políticas públicas

Los gobiernos desempeñan un papel fundamental en la creación de un marco legal que regule el desarrollo y uso de la IA, estableciendo límites claros para prevenir su uso malintencionado. Esto puede incluir leyes sobre la transparencia de los algoritmos, la responsabilidad por el contenido generado por IA y sanciones para quienes la utilicen con fines manipuladores. La Ley de Inteligencia Artificial de la Unión Europea es un ejemplo pionero en este sentido, buscando equilibrar la innovación con la protección de los derechos fundamentales. Es vital que estas regulaciones sean ágiles y se adapten a la rápida evolución tecnológica. La Comisión Europea ha estado liderando el camino en este frente: Conoce la estrategia de IA de la Comisión Europea.

Colaboración multidisciplinar

La complejidad del problema exige una colaboración estrecha entre diversos actores: gobiernos, empresas tecnológicas, academia, organizaciones de la sociedad civil y medios de comunicación. Los investigadores pueden desarrollar nuevas técnicas de detección y contramedidas, las empresas pueden implementar estas soluciones, los gobiernos pueden crear el marco legal y la sociedad civil puede educar y abogar por prácticas responsables. Solo un enfoque holístico permitirá abordar eficazmente las múltiples facetas de la manipulación con IA. La unión de esfuerzos es indispensable. Organizaciones como el Foro Económico Mundial también abordan estos temas desde una perspectiva global: Investiga las iniciativas de IA del Foro Económico Mundial.

Herramientas de verificación y contramedidas

Finalmente, la tecnología puede ser parte de la solución. El desarrollo y la implementación de herramientas avanzadas de verificación de hechos, software de detección de "deepfakes", sistemas de autenticación de contenido (como marcas de agua digitales o metadatos confiables) y antivirus de próxima generación son cruciales. Estas herramientas pueden ayudar a los usuarios y a las plataformas a identificar y mitigar la propagación de contenido manipulado. Apoyar a las organizaciones de "fact-checking" y a los periodistas de investigación que utilizan estas herramientas es también una parte vital de la estrategia. Chequeado es un gran ejemplo de organización de verificación de hechos en español: Consulta los análisis de Chequeado.

El papel de la responsabilidad individual y colectiva

Más allá de las soluciones tecnológicas y regulatorias, la protección contra la manipulación con IA reside en una profunda reflexión sobre nuestra responsabilidad individual y colectiva. Como usuarios, tenemos el poder de ser consumidores críticos de información, de no compartir contenido dudoso y de reportar abusos. Como sociedad, tenemos la responsabilidad de exigir a las empresas y gobiernos que actúen con transparencia y ética. El futuro digital que construyamos dependerá de nuestra capacidad para ser proactivos, adaptarnos y educar continuamente. Mi convicción es que la pasividad es nuestro mayor enemigo; debemos adoptar una postura activa y crítica ante el diluvio de información.

Conclusión: hacia un futuro digital resiliente

La inteligencia artificial es una fuerza transformadora, y su potencial para el bien es inmenso. Sin embargo, no podemos ignorar la sombra que proyecta en términos de manipulación y desinformación. Protegerse contra estas amenazas no es una tarea trivial; exige un enfoque integral que combine la educación ciudadana, el desarrollo tecnológico responsable, marcos regulatorios sólidos y una colaboración sin precedentes entre todos los actores relevantes. Solo a través de este esfuerzo concertado podremos asegurar que la IA sea una herramienta para el progreso humano y no un vector de división y engaño. El desafío es grande, pero la oportunidad de construir un futuro digital más seguro y transparente es aún mayor. Es un viaje que apenas comienza, y cada paso que damos hacia la concienciación y la acción nos acerca a un ecosistema digital más resiliente y confiable.

Inteligencia artificial Ciberseguridad Desinformación Ética de IA