La cuestión del derecho a morir con dignidad es, sin duda, una de las encrucijadas éticas más profundas y complejas de nuestra era. Toca fibras sensibles de autonomía personal, sufrimiento humano, compasión, moralidad y el papel del Estado. En este ya de por sí intrincado debate, irrumpen periódicamente figuras que, con ideas disruptivas, no solo lo avivan sino que lo propulsan hacia dimensiones antes impensables. Una de esas figuras es el doctor Philip Nitschke, conocido como el "Dr. Muerte" o el "Elon Musk de la eutanasia", quien ya había capturado la atención mundial con la creación de la cápsula Sarco. Ahora, Nitschke ha vuelto a generar una marea de controversia al proponer que la inteligencia artificial (IA) sea la encargada de autorizar el derecho a morir de las personas. Esta idea, que fusiona la tecnología de vanguardia con uno de los dilemas más íntimos de la existencia humana, nos obliga a pausar y a reflexionar profundamente sobre las implicaciones éticas, filosóficas, legales y sociales de confiar una decisión tan trascendental a un algoritmo. ¿Estamos realmente preparados para delegar la potestad sobre la vida y la muerte en una máquina, por sofisticada que sea?

El doctor Philip Nitschke y la cápsula Sarco: Un repaso a la controversia

Philip Nitschke no es un recién llegado al centro del huracán mediático y ético. Desde hace décadas, ha sido un acérrimo defensor del derecho de todo individuo a elegir cuándo y cómo poner fin a su vida, especialmente en casos de sufrimiento insoportable o enfermedad terminal. Su activismo le ha valido tanto el aplauso de defensores de la autonomía personal como la condena de grupos provida y organizaciones médicas tradicionales, quienes lo acusan de cruzar líneas rojas fundamentales. Su nombre se ha vuelto sinónimo de la "muerte asistida", y su trabajo ha empujado constantemente los límites de lo que la sociedad considera aceptable en este ámbito.

Nitschke: Visionario o provocador

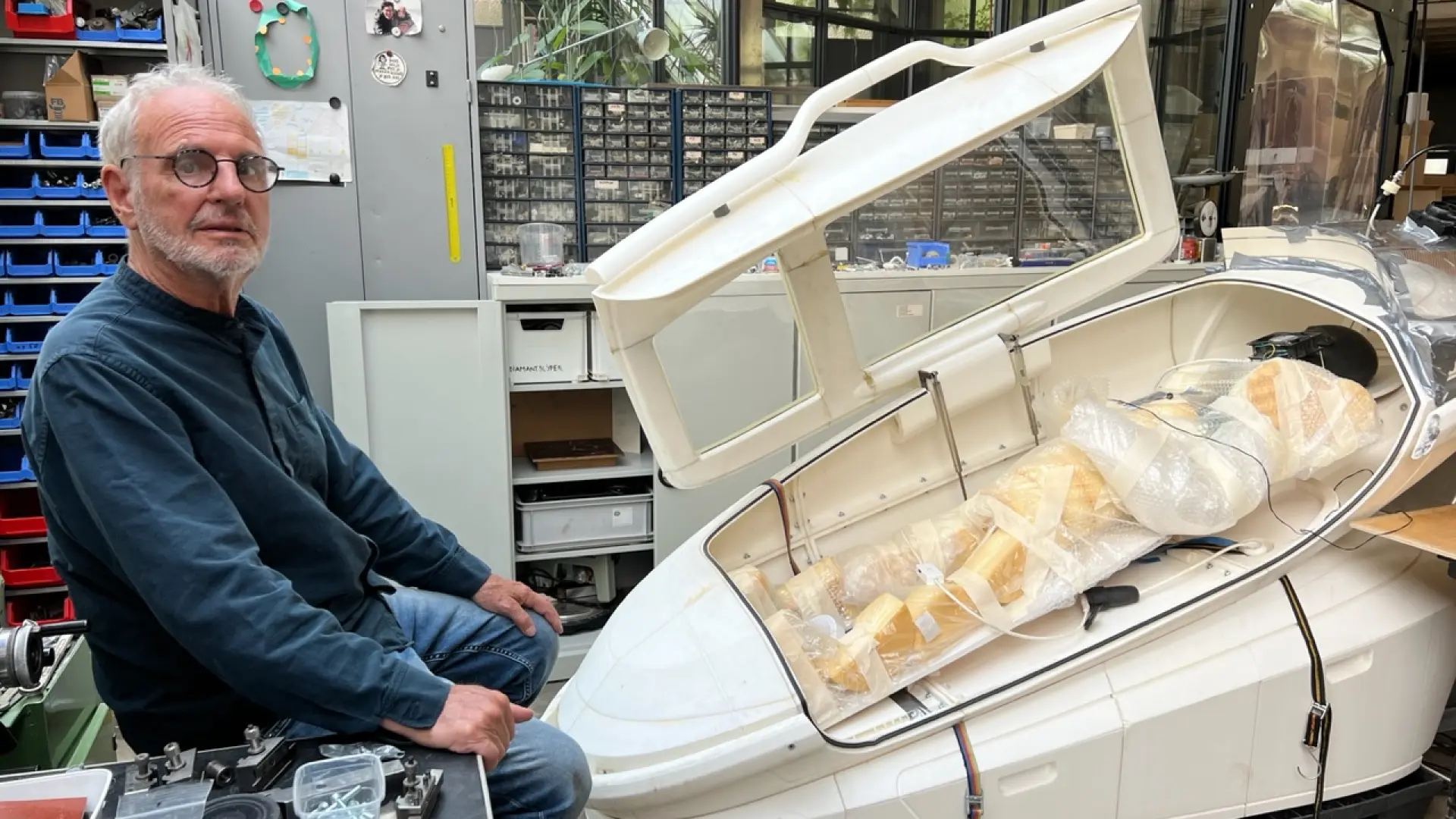

Para entender la magnitud de su última propuesta, es crucial recordar su invento anterior: la cápsula Sarco. Esta peculiar máquina, un diseño futurista que recuerda a una nave espacial o a un sarcófago moderno, fue concebida para permitir a una persona poner fin a su vida de manera pacífica y sin asistencia directa de terceros. El usuario ingresaría en la cápsula, respondería a una serie de preguntas para confirmar su intención y, si se considera competente, activaría el proceso. La cápsula liberaría nitrógeno, reduciendo rápidamente los niveles de oxígeno y provocando una muerte indolora en cuestión de minutos. La premisa detrás de Sarco era ofrecer una opción digna y controlada para aquellos que deseaban morir, buscando eludir las complejidades y restricciones legales de la eutanasia en muchos países. La Sarco no solo desafió la moralidad, sino que también planteó preguntas prácticas sobre la regulación y la accesibilidad. Aquí puedes encontrar más información sobre la cápsula Sarco y su funcionamiento.

Funcionamiento de la Sarco

El concepto de Sarco eliminaba la necesidad de un médico o enfermera para administrar la dosis letal, transfiriendo el control total al individuo. Nitschke argumentaba que esto democratizaba el derecho a morir, haciéndolo accesible a cualquier persona que, tras un proceso de validación, decidiera usarla. La cápsula se diseñó para ser imprimible en 3D, lo que, según Nitschke, haría que la tecnología fuera universalmente disponible. Sin embargo, su propuesta generó un intenso debate sobre la ética de la "muerte hazlo tú mismo" y la desmedicalización de un proceso que tradicionalmente ha estado bajo un estricto escrutinio médico y legal.

La inteligencia artificial como árbitro de la vida y la muerte

Ahora, Nitschke va un paso más allá. Su última provocación no se centra solo en el "cómo" morir, sino en el "quién" autoriza esa decisión. Propone que una inteligencia artificial sea la encargada de evaluar si una persona cumple los requisitos para acceder al derecho a morir. En su visión, esta IA operaría como un juez imparcial, analizando la información proporcionada por el individuo, su historial médico, sus declaraciones de voluntad y quizás incluso patrones de comunicación, para determinar si su deseo de morir es genuino, racional y libre de coacción.

El argumento de la objetividad

El principal argumento a favor de la IA, según Nitschke, es la objetividad. La máquina, libre de emociones, sesgos personales, creencias religiosas o presiones éticas que puedan afectar a un médico o un comité de ética humano, podría tomar una decisión puramente basada en datos y lógica. Esto, en teoría, podría agilizar el proceso, reducir la burocracia y eliminar la subjetividad humana que a menudo complica y prolonga la aprobación de la muerte asistida en muchas jurisdicciones. Para Nitschke, una IA podría ser la garante definitiva de la autonomía personal, asegurando que el deseo de morir de un individuo se respete sin interferencias emocionales o morales externas. Podría, además, operar 24/7, garantizando una accesibilidad constante.

Implicaciones éticas inmediatas

Sin embargo, esta propuesta no solo es audaz, sino profundamente inquietante. Inmediatamente surgen una miríada de preguntas que van al corazón de nuestra comprensión de lo que significa ser humano. ¿Puede una máquina comprender la complejidad del sufrimiento humano? ¿Es la "objetividad" siempre el camino correcto cuando se trata de decisiones de vida o muerte? ¿Y qué ocurre con el valor intrínseco de la vida, la compasión y la intervención humana en momentos de máxima vulnerabilidad? En mi opinión, la mera idea de una IA dictaminando sobre el derecho a morir es una pendiente resbaladiza hacia la deshumanización de un proceso que es, por definición, intensamente humano.

Dilemas éticos y filosóficos profundos

La propuesta de Nitschke no es solo un avance tecnológico; es una invitación a un profundo examen de nuestros valores fundamentales. Abordar esta idea requiere una inmersión en varios dilemas éticos y filosóficos que la humanidad ha debatido durante milenios, ahora con un giro digital.

La autonomía individual frente al algoritmo

El derecho a la autonomía personal es la piedra angular del argumento de Nitschke. Sin embargo, ¿puede una IA realmente validar la autonomía? La autonomía no es solo la capacidad de elegir, sino también la capacidad de elegir libremente y con pleno conocimiento. ¿Cómo puede un algoritmo discernir si una persona está bajo presión, sufriendo de depresión no diagnosticada que nubla su juicio, o experimentando un deseo transitorio de morir que podría revertirse con apoyo psicológico? La validación de la autonomía requiere una comprensión matizada del estado mental, emocional y social de un individuo, algo que parece ir más allá de las capacidades actuales o futuras predecibles de un sistema de IA. Los humanos, con su capacidad de empatía y razonamiento contextual, son a menudo esenciales para estas valoraciones complejas. La Enciclopedia de Filosofía de Stanford aborda el concepto de autonomía moral en profundidad.

La subjetividad del sufrimiento y la empatía de la máquina

El sufrimiento humano es inherentemente subjetivo. Lo que para una persona es insoportable, para otra puede ser manejable con el apoyo adecuado. La IA se basa en datos y patrones. ¿Cómo se traduciría el "sufrimiento insoportable" en un conjunto de datos cuantificables que un algoritmo pueda procesar? ¿Se basaría en informes médicos, autoevaluaciones, o patrones de lenguaje? Ninguno de estos puede capturar la totalidad de la experiencia de un ser humano que lucha con el dolor, la desesperanza o la pérdida de significado. La empatía, la capacidad de comprender y compartir los sentimientos de otro, es una cualidad fundamental en cualquier proceso de atención al final de la vida. Es lo que permite a los profesionales de la salud ofrecer apoyo, consuelo y a veces, incluso, una razón para continuar. Una máquina, por su propia naturaleza, carece de empatía. Su "decisión" sería fría, calculada, y sin ese toque humano que, en momentos tan críticos, puede ser la diferencia entre una elección irreversible y un cambio de perspectiva. Considero que en decisiones de este calibre, la ausencia de empatía es una falla crítica e insalvable.

Errores, sesgos y la cuestión de la responsabilidad

Los sistemas de IA no son infalibles. Se entrenan con datos, y esos datos pueden contener sesgos inherentes de la sociedad que los generó. Si una IA fuera entrenada con datos predominantemente de un grupo demográfico específico o con ciertos prejuicios culturales sobre la muerte y el valor de la vida, ¿podría discriminar involuntariamente a otros? ¿Qué pasa si el algoritmo comete un "error"? ¿Quién sería el responsable si una IA autoriza la muerte de una persona que, con el apoyo adecuado, podría haber encontrado una razón para vivir? La atribución de responsabilidad en casos de fallos de IA ya es un terreno legal y ético pantanoso en áreas menos sensibles como la conducción autónoma. En el contexto de la vida y la muerte, esta ambigüedad sería inaceptable. No podemos darnos el lujo de "errores" en este ámbito. Nature publicó un artículo interesante sobre los desafíos de la ética en la IA.

El riesgo del "pendiente resbaladizo"

Uno de los argumentos más recurrentes contra la legalización de la eutanasia y el suicidio asistido es el del "pendiente resbaladizo". La preocupación es que, una vez que se abren las puertas a estas prácticas bajo ciertas condiciones, los criterios se irán relajando progresivamente hasta abarcar situaciones que inicialmente se consideraban inaceptables. Introducir una IA para autorizar el derecho a morir podría exacerbar este temor. Si la "objetividad" de la IA se convierte en el estándar, ¿qué impediría que los criterios se expandieran para incluir a personas con enfermedades menos graves, discapacidades o incluso simplemente personas "cansadas de vivir" sin afecciones terminales? El miedo es que se desvalorice la vida humana y se normalice la idea de la muerte como una "solución" fácil, sin haber explorado todas las vías de apoyo y cuidado.

Desafíos tecnológicos y la viabilidad de la propuesta

Más allá de los dilemas éticos, la propuesta de Nitschke también plantea enormes desafíos tecnológicos y prácticos que, a día de hoy, parecen insuperables.

Desarrollo, entrenamiento y validación de la IA

¿Cómo se entrenaría un algoritmo para tomar una decisión tan compleja? Requeriría un conjunto de datos masivo y extremadamente diverso que reflejara la experiencia humana en su totalidad. ¿Quién recopilaría esos datos y bajo qué criterios? ¿Cómo se enseñaría a la IA a discernir entre un deseo genuino de morir y un grito de ayuda, entre la desesperación temporal y una decisión irrevocable? La IA actual es muy buena en tareas específicas y bien definidas, pero las decisiones que involucran la vida humana son inherentemente multifactoriales, dinámicas y profundamente contextuales. Validar un algoritmo para una función tan crítica sería una tarea monumental, y la mínima desviación en su rendimiento tendría consecuencias catastróficas.

Seguridad, privacidad y resiliencia del sistema

Un sistema que decide sobre el derecho a morir contendría la información más sensible y personal de los individuos. La seguridad de estos datos sería primordial. ¿Cómo se protegería de ciberataques, manipulaciones o accesos no autorizados? ¿Podría ser "hackeado" para permitir o denegar la muerte a personas de forma fraudulenta? Además, la resiliencia del sistema sería vital. Un fallo técnico, un error de software o un corte de energía no pueden ser tolerables en un sistema que gestiona la vida o la muerte. La infraestructura necesaria para mantener un sistema así con un nivel de seguridad y fiabilidad cercano al 100% sería gigantesca. La privacidad también es una preocupación enorme: la cantidad de datos personales y médicos que un individuo tendría que compartir con la IA para su evaluación sería extensa, y la garantía de su confidencialidad sería crucial.

Marco legal y aceptación social

Incluso si los desafíos éticos y tecnológicos pudieran resolverse (lo cual veo muy improbable), la implementación de un sistema de IA para autorizar la muerte asistida chocaría con los marcos legales y regulatorios actuales en la mayoría de los países. Las leyes de eutanasia y suicidio asistido, donde existen, son extremadamente restrictivas y requieren la intervención humana en cada etapa del proceso. Adaptar estas leyes para permitir la decisión de una máquina sería un proceso legalmente tortuoso y políticamente explosivo. La aceptación social es otro obstáculo formidable. Es difícil imaginar que la mayoría de las sociedades occidentales, con sus profundas raíces éticas y religiosas, aceptarían de buen grado que una IA sea la puerta de entrada a la muerte.

Perspectivas y el debate actual

La propuesta de Nitschke, aunque controvertida, fuerza una conversación necesaria sobre el futuro de la muerte asistida y el papel creciente de la tecnología en decisiones que hasta ahora han sido exclusivas de los humanos.

Voces a favor y en contra

Mientras Nitschke y sus seguidores argumentan la eficiencia y la objetividad de la IA, la mayoría de los bioeticistas, médicos y expertos en IA se muestran profundamente escépticos. Argumentan que la vida y la muerte son decisiones que exigen una profunda reflexión humana, compasión y un entendimiento que va más allá de los algoritmos. Organizaciones como la Asociación Médica Mundial han mantenido históricamente una postura contraria a la eutanasia y el suicidio asistido, enfatizando el papel del médico como cuidador y sanador, no como facilitador de la muerte. La introducción de la IA en este proceso complicaría aún más esta postura.

Mi perspectiva sobre la propuesta

No puedo negar el atractivo, para algunos, de una solución aparentemente "imparcial" y "eficiente" a un problema tan angustiante. La idea de que una máquina pueda eliminar el sesgo humano y la burocracia en un momento de profundo sufrimiento puede sonar seductora. Sin embargo, en mi opinión, es una visión peligrosamente simplista de la complejidad humana. La dignidad de la muerte no reside en la eficiencia de su aprobación, sino en la profundidad de la consideración, el apoyo compasivo y el respeto absoluto por la autonomía de la persona en su totalidad. Delegar esta decisión a una IA es, en última instancia, una deshumanización. Se corre el riesgo de convertir un acto de profundo significado personal en una transacción algorítmica. Creo firmemente que, aunque la IA tiene un papel crucial en la optimización de muchos aspectos de la medicina (diagnóstico, tratamiento, etc.), existen límites éticos infranqueables cuando se trata de decisiones que tocan el núcleo de la existencia, la conciencia y la dignidad humana. La muerte asistida, en mi opinión, debe seguir siendo un proceso profundamente humano, con médicos, psicólogos y especialistas que puedan ofrecer empatía, asesoramiento y comprensión, algo que ninguna IA podrá replicar verdaderamente.

El futuro de la muerte asistida en la era digital

La propuesta de Nitschke, por radical que parezca, nos obliga a confrontar el avance imparable de la tecnología y sus implicaciones para las áreas más íntimas de nuestra vida. A medida que la IA se vuelve más sofisticada, es inevitable que surjan más debates sobre su papel en la salud, la ética y, eventualmente, la muerte. Es vital que estas conversaciones se lleven a cabo de manera abierta, informada y con una base ética sólida. No podemos permitir que la fascinación por la innovación tecnológica nuble nuestro juicio sobre los valores humanos fundamentales.

Conclusión: Reflexiones finales sobre una propuesta divisiva

La idea de que una IA pueda autorizar el derecho a morir es un reflejo de hasta dónde estamos dispuestos a llevar la automatización y la delegación de decisiones cruciales a la tecnología. Philip Nitschke, una vez más, ha logrado encender un debate global, forzándonos a examinar las intersecciones entre la autonomía individual, la ética médica, el desarrollo tecnológico y la esencia misma de la condición humana. Mientras que la eficiencia y la objetividad que una IA podría ofrecer son teóricamente atractivas, los riesgos éticos, la imposibilidad de replicar la empatía humana y los desafíos prácticos que presenta un sistema así son inmensos. La vida y la muerte son demasiado complejas, demasiado personales y demasiado valiosas para ser reducidas a un algoritmo. La intervención humana, con su capacidad de compasión, juicio ético y discernimiento contextual, sigue siendo y debe seguir siendo indispensable en cualquier proceso que contemple el final de la vida. Este debate no es solo sobre tecnología; es sobre quiénes somos como sociedad y qué valores priorizamos en la era digital.

La Organización Mundial de la Salud ofrece un punto de vista sobre la eutanasia y el suicidio asistido. Un análisis jurídico-ético sobre la eutanasia.

#Eutanasia #InteligenciaArtificial #DerechoAMorir #ÉticaIA