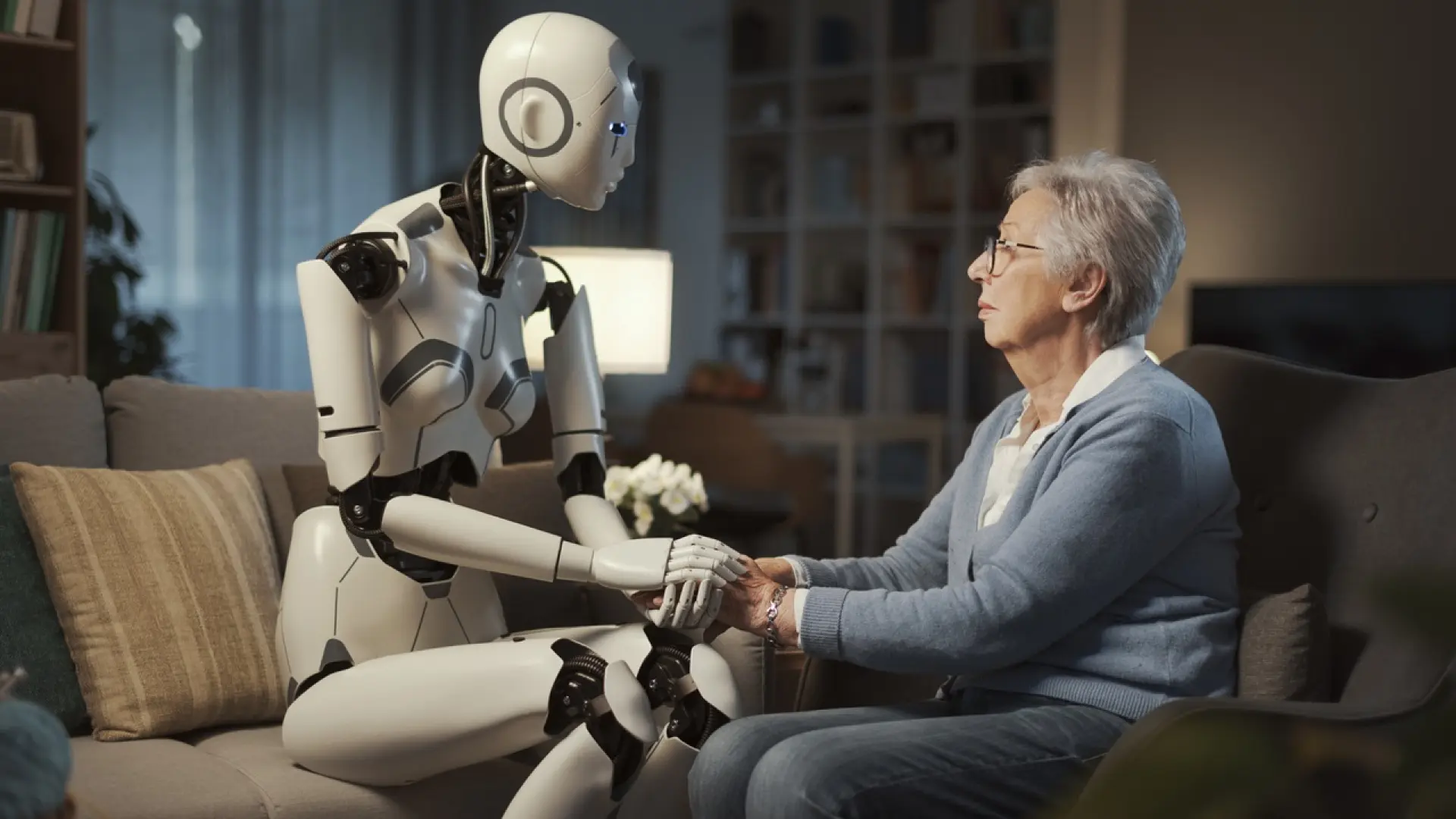

En un mundo cada vez más digitalizado, donde la inteligencia artificial (IA) promete revolucionar casi todos los aspectos de nuestra existencia, desde la gestión de ciudades hasta la personalización de nuestra experiencia de compra, emerge una voz de cautela, especialmente en el ámbito más delicado y personal: la salud mental. La capacidad de las máquinas para procesar vastas cantidades de datos, aprender de patrones y ofrecer respuestas casi instantáneas es, sin duda, asombrosa. Sin embargo, cuando se trata del intrincado tapiz de las emociones humanas, la complejidad de los traumas, las sutilezas de la empatía o el poder sanador de una conexión genuina, los expertos están alzando la voz. Advierten que, si bien la IA puede ser una herramienta poderosa y complementaria, jamás debe erigirse como el sustituto del acompañamiento humano en el cuidado de nuestra psique. Esta es una línea roja fundamental que, de ser cruzada, podría acarrear consecuencias imprevisibles y profundamente perjudiciales para el bienestar de las personas. La conversación no gira en torno a rechazar el progreso, sino a comprender sus límites inherentes, especialmente cuando el objeto de su aplicación es la esencia misma de lo que nos define como seres humanos. Es un debate crucial que exige reflexión, ética y, sobre todo, una perspectiva centrada en la humanidad por encima de la eficiencia algorítmica.

La promesa de la IA en la salud mental: un aliado potencial, no un reemplazo

La irrupción de la inteligencia artificial en el campo de la salud mental no ha estado exenta de un entusiasmo considerable. Sus defensores señalan el vasto potencial para abordar algunos de los desafíos más persistentes que enfrenta el sistema actual: la escasez de profesionales, la inaccesibilidad en zonas rurales o para poblaciones marginadas, el estigma asociado a la búsqueda de ayuda y la necesidad de herramientas de diagnóstico y seguimiento más precisas y eficientes.

Pensemos, por ejemplo, en los chatbots especializados, diseñados para ofrecer apoyo inicial, realizar cribados de síntomas o incluso guiar a los usuarios a través de ejercicios de terapia cognitivo-conductual de baja intensidad. Estas herramientas pueden ser un primer punto de contacto para quienes dudan en buscar ayuda profesional, ofreciendo un espacio anónimo y disponible 24/7. Algunos sistemas de IA avanzados ya demuestran la capacidad de analizar patrones del habla, expresiones faciales o incluso el uso del lenguaje en redes sociales para detectar signos tempranos de depresión, ansiedad o riesgo de suicidio, alertando a profesionales o contactos cercanos de manera preventiva. La IA puede facilitar el monitoreo de estados de ánimo a largo plazo, permitiendo a los terapeutas obtener una visión más completa y objetiva de la evolución de sus pacientes entre sesiones. Además, puede servir como una potente herramienta administrativa, aliviando la carga burocrática de los profesionales y permitiéndoles dedicar más tiempo a la atención directa.

No podemos ignorar la promesa de la IA para democratizar el acceso a la atención de salud mental, especialmente en regiones donde los recursos son limitados. En países en desarrollo o áreas con alta demanda y baja oferta de especialistas, una herramienta basada en IA podría ofrecer una ayuda básica invaluable. Yo mismo he observado cómo ciertas aplicaciones de mindfulness y bienestar, potenciadas por algoritmos, pueden ser un excelente punto de partida para que las personas exploren técnicas de relajación y autoconocimiento. Su capacidad para procesar información y generar respuestas rápidas las convierte en un recurso atractivo en un mundo que valora la inmediatez. Sin embargo, esta misma inmediatez y la apariencia de "comprensión" pueden ser engañosas, ocultando una limitación fundamental que los expertos no se cansan de señalar. La eficiencia y la escalabilidad, por muy deseables que sean, no pueden ser los únicos criterios de evaluación en un dominio tan sensible. Es crucial que, al explorar estas aplicaciones, mantengamos siempre en mente que la tecnología es un medio, no un fin, y que su objetivo último debe ser complementar, no reemplazar, la insustituible calidez y sabiduría del acompañamiento humano.

La advertencia de los expertos: un límite fundamental

A pesar de los avances y el entusiasmo justificado por el potencial de la inteligencia artificial, una creciente coalición de psicólogos, psiquiatras, neurocientíficos y bioeticistas ha emitido una clara y contundente advertencia: la IA, por sofisticada que sea, nunca debe sustituir el acompañamiento humano en el ámbito de la salud mental. Esta no es una mera cuestión de preferencia, sino una comprensión profunda de la naturaleza de la psique humana y de lo que realmente constituye un proceso terapéutico efectivo.

La razón principal reside en la intrínseca incapacidad de la IA para replicar la empatía genuina, la intuición, el juicio ético matizado y la comprensión profunda del contexto humano complejo que son inherentes a la interacción terapéutica. Un algoritmo puede simular empatía, puede aprender a responder con frases de apoyo o a reconocer patrones en el lenguaje que sugieran angustia. Pero esta es una "empatía" programada, carente de la experiencia vivida, de la resonancia emocional que se produce cuando un ser humano se conecta con otro en un nivel profundo. La terapia es, en esencia, una relación; una relación donde la confianza, la validación y la seguridad se construyen a través de la interacción entre dos personas. Es en ese espacio de vulnerabilidad compartida y conexión auténtica donde se produce la verdadera sanación y el crecimiento. Un terapeuta humano no solo escucha las palabras, sino que percibe los silencios, las microexpresiones faciales, el tono de voz, la historia personal y cultural que subyace a cada problema. Interpreta el contexto, las dinámicas relacionales y las complejidades de la experiencia humana de una manera que un algoritmo, por avanzado que sea, no puede hacer. El juicio clínico humano implica discernir matices éticos y morales, adaptarse a situaciones imprevistas y tomar decisiones que van más allá de un conjunto de reglas preestablecidas.

La deshumanización del cuidado es un peligro real si dependemos excesivamente de la IA. La salud mental no es una serie de problemas técnicos a resolver con una solución algorítmica; es una parte integral de nuestra identidad y nuestra experiencia vital. Reducir la complejidad del sufrimiento humano a datos y algoritmos corre el riesgo de empobrecer la propia experiencia de la ayuda, de trivializar el dolor y de alejarnos aún más de lo que, paradójicamente, a menudo buscamos en la terapia: una reconexión con nuestra propia humanidad y con la de los demás. Esta advertencia no busca frenar el progreso, sino cimentarlo en una base ética y humana inquebrantable. Para más información sobre la ética en la IA, se puede consultar el trabajo de la UNESCO sobre la ética de la inteligencia artificial.

Riesgos específicos de la IA en la salud mental

Cuando hablamos de la aplicación de la IA en la salud mental, no estamos ante una mera extensión de herramientas digitales existentes. Nos adentramos en un terreno donde las vulnerabilidades humanas son elevadas y las implicaciones éticas profundas. Por ello, es imperativo desglosar los riesgos específicos que los expertos han identificado.

Falta de empatía genuina y conexión humana

Como ya he mencionado, la incapacidad de la IA para sentir empatía es su mayor limitación. Los algoritmos pueden procesar y emitir respuestas que simulan comprensión y apoyo, pero carecen de la capacidad de experimentar el mundo interno de otra persona. La relación terapéutica es un pilar fundamental en la mayoría de los enfoques de salud mental. Esta relación, construida sobre la confianza, el respeto mutuo, la autenticidad y la empatía bidireccional, es el vehículo a través del cual el paciente se siente seguro para explorar sus pensamientos y emociones más profundos. Un bot no puede ofrecer una mirada de comprensión que valide el dolor, un silencio oportuno que invite a la reflexión, ni la sabiduría derivada de la experiencia humana compartida. La curación, a menudo, no reside solo en las "soluciones" o los "consejos", sino en el proceso de ser verdaderamente visto y escuchado por otro ser humano. Delegar esto a una máquina es arriesgarse a perder la esencia misma de lo que hace efectiva a la terapia.

Sesgos algorítmicos y equidad en el acceso

Los sistemas de IA aprenden de los datos con los que son entrenados. Si estos datos reflejan sesgos existentes en la sociedad –ya sean raciales, de género, socioeconómicos o culturales–, la IA no solo perpetuará esos sesgos, sino que puede amplificarlos. Esto es particularmente preocupante en salud mental. Un algoritmo entrenado predominantemente con datos de poblaciones occidentales, por ejemplo, podría malinterpretar o ignorar expresiones de angustia culturalmente específicas en otras poblaciones, llevando a diagnósticos erróneos o a una atención inadecuada. La equidad en el acceso a la salud mental, que la IA promete mejorar, podría verse socavada si las herramientas desarrolladas solo sirven eficazmente a un segmento de la población, dejando a otros aún más desatendidos. Asegurar que los conjuntos de datos de entrenamiento sean diversos y representativos es un desafío monumental y continuo que requiere una supervisión constante y ética. Un recurso interesante sobre este tema es el artículo de la revista Nature sobre los sesgos en la IA de salud (puede requerir suscripción o acceso académico).

Privacidad y seguridad de los datos sensibles

La información compartida en el contexto de la salud mental es de las más íntimas y sensibles que una persona puede revelar. Los sistemas de IA, para ser efectivos, requieren acceder y procesar grandes volúmenes de estos datos. Esto plantea riesgos significativos en términos de privacidad y seguridad. ¿Cómo se almacenan estos datos? ¿Quién tiene acceso a ellos? ¿Cómo se utilizan para entrenar modelos futuros? Una brecha de seguridad podría tener consecuencias devastadoras para los individuos, desde la exposición de información personal hasta la estigmatización o discriminación. Además, existe la preocupación sobre cómo las empresas tecnológicas podrían monetizar estos datos, incluso de forma anonimizada, lo que plantea serias dudas éticas sobre la explotación de la vulnerabilidad humana. La regulación y la protección de datos deben ser extremadamente robustas, mucho más allá de las prácticas actuales en otros sectores.

La dilución de la responsabilidad y la ética

Cuando un sistema de IA ofrece un diagnóstico, una recomendación o incluso "consuelo", ¿quién es el responsable si algo sale mal? Si una persona toma una decisión perjudicial basándose en la interacción con una IA, ¿recae la responsabilidad en el desarrollador del algoritmo, en el proveedor del servicio, en el usuario o en la propia IA? Esta dilución de la responsabilidad ética es un campo minado legal y moral. Los profesionales de la salud mental están sujetos a estrictos códigos de ética y estándares de cuidado. La IA, en su estado actual, no puede adherirse a esos mismos códigos ni asumir la responsabilidad legal o moral de sus "acciones". Esto subraya la necesidad de que la intervención humana sea siempre el punto final de control y supervisión.

El riesgo de crear una dependencia tecnológica

Una preocupación menos obvia pero igualmente importante es el riesgo de que las personas desarrollen una dependencia excesiva de las herramientas de IA para su bienestar emocional. Si una IA ofrece apoyo constante y sin juicio, ¿podría esto disuadir a las personas de buscar interacciones humanas reales, contribuyendo paradójicamente a un mayor aislamiento social? La interacción con una máquina es fundamentalmente diferente a la interacción con un ser humano. Mientras que un ser humano puede empujar suavemente a una persona a salir de su zona de confort, a enfrentar desafíos relacionales o a desarrollar habilidades de afrontamiento en el mundo real, una IA podría, sin intención, reforzar una burbuja de "seguridad" digital que aísle aún más al individuo. El objetivo de la terapia es empoderar a las personas para que naveguen por la vida con mayor resiliencia y conexión; una dependencia de la tecnología podría obstaculizar este objetivo. Un artículo sobre el uso de la IA en terapia de la American Psychological Association explora estas dinámicas (en inglés).

El rol complementario de la IA: hacia una integración ética

Reconocer las limitaciones de la IA en la salud mental no implica rechazar por completo su potencial. Al contrario, nos insta a forjar un camino donde la tecnología y la humanidad no compitan, sino que se complementen de manera ética y efectiva. La pregunta clave no es "IA versus humanos", sino "cómo podemos integrar la IA de forma inteligente para potenciar el cuidado humano".

La IA, vista como una herramienta de apoyo, puede liberar a los profesionales de tareas repetitivas o administrativas, permitiéndoles dedicar más tiempo y energía a la interacción directa con los pacientes. Por ejemplo, los sistemas de IA podrían gestionar citas, recordatorios, o incluso procesar y resumir grandes volúmenes de notas de sesiones, destacando patrones o información relevante para el terapeuta. Esto optimiza la eficiencia y reduce el agotamiento profesional, un problema endémico en el sector de la salud mental.

Además, la IA tiene un papel crucial en la recopilación y análisis de datos objetivos. Un dispositivo wearable o una aplicación en el smartphone, asistida por IA, podría monitorear patrones de sueño, niveles de actividad física, uso de redes sociales o incluso variaciones en el tono de voz a lo largo del tiempo. Estos datos, cuando se presentan al terapeuta, ofrecen una visión más holística y longitudinal del estado del paciente, que complementa la información subjetiva obtenida en las sesiones. Este tipo de datos objetivos puede ser invaluable para afinar diagnósticos, personalizar planes de tratamiento y evaluar la efectividad de las intervenciones. Un ejemplo de este monitoreo se explora en el campo de la Asociación Americana de Psiquiatría (en inglés).

Asimismo, la IA puede ser un recurso de "primer filtro" o de "baja intensidad". Para personas que experimentan una angustia leve o que simplemente buscan recursos educativos y técnicas de autoayuda, un chatbot o una aplicación bien diseñada pueden ser un punto de partida excelente. Pueden normalizar la búsqueda de ayuda, ofrecer estrategias de afrontamiento básicas y, lo que es crucial, guiar a los usuarios hacia la atención humana cuando la situación lo amerite. Es decir, actuar como un puente, no como un destino final.

Es fundamental que cualquier integración de la IA en la salud mental esté bajo una supervisión humana constante. Los diagnósticos, los planes de tratamiento y las decisiones críticas deben ser siempre prerrogativa de un profesional capacitado. La IA debe ser vista como un copiloto, que asiste, alerta y procesa información, pero cuya "conducción" final sigue siendo responsabilidad del experto humano. Esta integración ética no solo salvaguarda la calidad del cuidado, sino que también refuerza la confianza en el sistema, asegurando que la tecnología sirva al ser humano, y no al revés.

Regulación, ética y formación: el camino a seguir

El desarrollo acelerado de la inteligencia artificial exige una respuesta igualmente rápida y ponderada en términos de regulación, ética y formación. Si bien la innovación es bienvenida, la ausencia de marcos claros podría llevar a un despliegue irresponsable de herramientas de IA en un campo tan sensible como la salud mental.

La urgencia de establecer marcos regulatorios claros no puede subestimarse. Los gobiernos y las organizaciones internacionales deben trabajar en conjunto para desarrollar políticas que aborden la seguridad, la privacidad de los datos, la transparencia algorítmica y la responsabilidad legal. Es esencial que se definan estándares mínimos para el desarrollo, prueba y despliegue de soluciones de IA en salud mental, asegurando que estas herramientas sean seguras, efectivas y equitativas. Esto implica, por ejemplo, auditar regularmente los algoritmos para detectar y mitigar sesgos, establecer protocolos claros para la gestión de datos sensibles y garantizar que los usuarios entiendan cómo funciona la IA y cuáles son sus limitaciones. La Unión Europea, con su Ley de Inteligencia Artificial, está marcando un precedente importante en este sentido, categorizando los sistemas de IA de alto riesgo y estableciendo requisitos estrictos para su uso.

Paralelamente a la regulación, la bioética aplicada a la IA es un campo en plena ebullición y de vital importancia. Debemos reflexionar profundamente sobre preguntas como: ¿Qué constituye un "buen" resultado para la IA en salud mental? ¿Cómo equilibramos la autonomía del paciente con las capacidades predictivas de la IA? ¿Quién define y supervisa los principios éticos que guían el diseño de estas herramientas? Los comités de ética deben jugar un papel central en la evaluación de nuevas tecnologías, asegurando que su implementación esté alineada con los valores humanos y los derechos fundamentales de las personas. La transparencia en el diseño de los algoritmos y la explicabilidad de sus decisiones son principios éticos fundamentales que deben ser no negociables. Un ejemplo de reflexión ética lo encontramos en las directrices de la Comisión Europea sobre la IA confiable.

Finalmente, la formación de profesionales de la salud mental es crucial. No podemos esperar que los terapeutas de hoy y mañana naveguen por este nuevo paisaje sin las herramientas y el conocimiento adecuados. Necesitan comprender qué es la IA, cómo funciona, cuáles son sus beneficios y, críticamente, cuáles son sus limitaciones éticas y prácticas. Esto no solo implica familiarizarse con la tecnología, sino también desarrollar una alfabetización crítica que les permita evaluar las afirmaciones sobre la IA y tomar decisiones informadas sobre su uso en su práctica. Al mismo tiempo, es fundamental educar al público. Las personas deben ser conscientes de lo que pueden esperar de la IA en salud mental, diferenciando el apoyo complementario de la sustitución humana, para evitar expectativas irreales o una dependencia peligrosa. Es un camino de aprendizaje mutuo, donde tecnólogos, clínicos, pacientes y reguladores deben colaborar activamente para construir un futuro don