La inteligencia artificial (IA) ha dejado de ser una promesa futurista para convertirse en el motor principal de la innovación tecnológica de nuestro tiempo. Desde la automatización de tareas cotidianas hasta el desarrollo de modelos lingüísticos masivos capaces de generar texto coherente y creativo, la IA redefine constantemente los límites de lo posible. Sin embargo, detrás de cada avance espectacular en el campo de la IA, existe un componente fundamental que a menudo permanece en segundo plano: el hardware. La capacidad de procesamiento, la eficiencia energética y la velocidad de acceso a la memoria son cuellos de botella que dictan no solo la viabilidad de los algoritmos más ambiciosos, sino también la velocidad a la que podemos seguir innovando. Es en este contexto de demanda insaciable por mayor poder computacional donde emerge Ironwood, el más reciente y ambicioso proyecto de Google en el ámbito de los semiconductores, diseñado específicamente para dominar la era de la IA.

Ironwood no es solo un nuevo chip; es una declaración de intenciones por parte de Google, una pieza estratégica que busca consolidar su liderazgo en el panorama global de la inteligencia artificial. En un mercado cada vez más competitivo, donde gigantes tecnológicos y startups innovadoras batallan por desarrollar la infraestructura definitiva para la IA, la introducción de un chip "ultrapotente" como Ironwood podría cambiar las reglas del juego. Nos encontramos en un momento pivotal donde el software más sofisticado exige un hardware igualmente avanzado, y parece que Google, con Ironwood, ha respondido a esa llamada con una solución que promete empujar aún más las fronteras de lo que la IA puede lograr. Acompáñenos a desglosar qué hace a Ironwood tan especial, cómo se integra en el vasto ecosistema de Google y qué impacto podría tener en el futuro de la inteligencia artificial.

Qué es Ironwood y por qué es relevante

Para entender la trascendencia de Ironwood, primero debemos situarlo en el contexto actual del desarrollo de la inteligencia artificial. Los algoritmos de IA, especialmente las redes neuronales profundas que alimentan la mayoría de los avances recientes —desde la visión por computadora hasta el procesamiento del lenguaje natural—, requieren una cantidad ingente de cálculos paralelos. Históricamente, esta carga computacional era manejada por las unidades de procesamiento gráfico (GPU) de uso general, diseñadas originalmente para renderizar gráficos en videojuegos. Sin embargo, a medida que la IA se volvía más compleja y omnipresente, surgió una necesidad crítica de hardware más especializado y eficiente.

Google fue uno de los pioneros en esta dirección con la introducción de sus unidades de procesamiento tensorial (TPU, por sus siglas en inglés), diseñadas desde cero para acelerar las cargas de trabajo de aprendizaje automático. Los TPUs han sido la columna vertebral de la infraestructura de IA de Google, potenciando desde sus propios servicios internos (como la Búsqueda y Google Assistant) hasta su plataforma en la nube. Ironwood, por lo que sabemos, representa la próxima generación de esta filosofía: un chip aún más optimizado, más potente y más eficiente, concebido para las demandas de la IA de próxima generación.

Su relevancia radica en varios pilares. Primero, la escala. Los modelos de IA actuales, como los grandes modelos de lenguaje (LLM), pueden tener cientos de miles de millones de parámetros. Entrenar y ejecutar estos modelos eficientemente requiere una capacidad de cómputo que pocos chips pueden ofrecer. Ironwood se posiciona como una solución para abordar esta escala masiva. Segundo, la eficiencia. La energía consumida por los centros de datos que ejecutan IA es enorme, y un chip más eficiente no solo reduce los costos operativos, sino que también tiene un impacto ambiental positivo. Finalmente, la innovación. Al proporcionar una plataforma de hardware superior, Ironwood abre la puerta a arquitecturas de IA aún más ambiciosas, permitiendo a investigadores y desarrolladores experimentar con modelos más grandes y complejos que podrían llevar a avances inimaginables.

En esencia, Ironwood es la respuesta de Google a la inevitable progresión de la IA: a medida que los algoritmos se hacen más inteligentes, el hardware debe seguir el ritmo, no solo incrementando la fuerza bruta, sino también optimizando cada aspecto del procesamiento para tareas específicas de inteligencia artificial. Es un recordatorio de que la carrera por la supremacía en IA se libra tanto en el código como en el silicio.

La arquitectura detrás de la potencia

La verdadera magia de un chip de IA como Ironwood no reside solo en su nombre o en la promesa de "ultrapotencia", sino en la intrincada arquitectura que lo sustenta. Si bien Google mantiene la mayoría de los detalles técnicos específicos bajo estricta confidencialidad, podemos inferir mucho sobre su diseño basándonos en las tendencias actuales del hardware de IA y la trayectoria de los propios TPUs de Google.

En el corazón de Ironwood, es muy probable que encontremos una arquitectura altamente paralela, diseñada para ejecutar miles, si no millones, de operaciones matemáticas simultáneamente. Las redes neuronales profundas, al fin y al cabo, son esencialmente gigantescas operaciones de multiplicación de matrices y tensores. Un chip optimizado para IA destaca por tener un gran número de unidades de procesamiento tensorial (o equivalentes) que pueden realizar estas operaciones a una velocidad vertiginosa. Esto difiere fundamentalmente de una CPU de propósito general, que está optimizada para la flexibilidad y la ejecución secuencial de un amplio rango de instrucciones.

Uno de los aspectos clave donde Ironwood, como cualquier acelerador de IA de vanguardia, seguramente innova es en la memoria. El "cuello de botella de Von Neumann" – la limitación de la velocidad y el ancho de banda entre la CPU y la memoria – es un desafío crítico en la computación de IA. Para modelos masivos, el movimiento de datos entre los núcleos de procesamiento y la memoria externa puede consumir una parte significativa del tiempo total de ejecución y de la energía. Es previsible que Ironwood integre memoria de alto ancho de banda (HBM, High Bandwidth Memory) directamente en el mismo paquete, o incluso en el mismo die, para minimizar la latencia y maximizar el flujo de datos. Esto permite que los procesadores tengan acceso a los pesos y activaciones del modelo casi instantáneamente, lo cual es vital para el entrenamiento y la inferencia de modelos grandes.

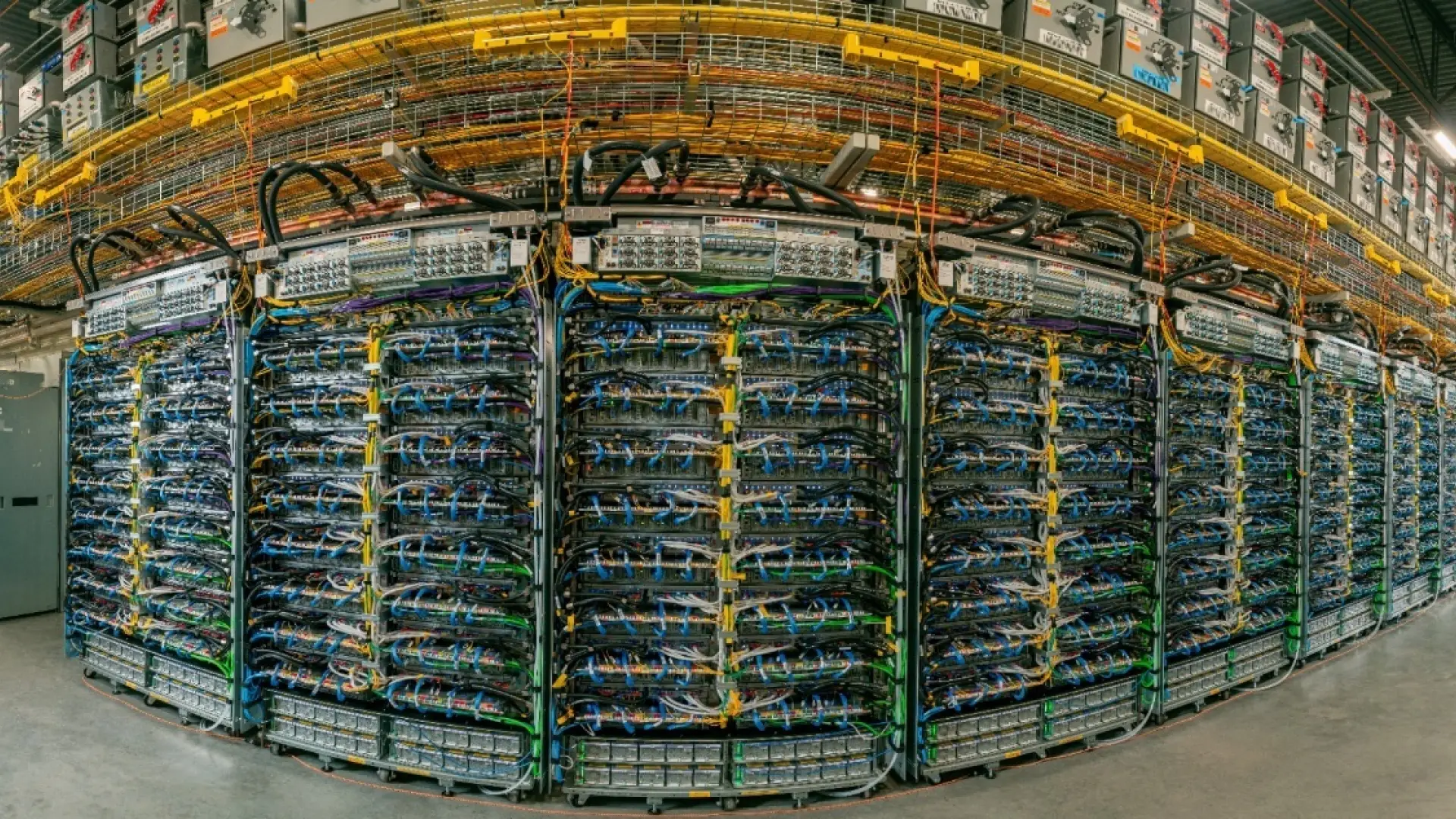

Otro elemento fundamental sería la conectividad inter-chip y intra-chip. Para lograr una potencia "ultrapotente", es probable que Ironwood no funcione solo, sino en clústeres masivos. Esto implica enlaces de comunicación de muy alta velocidad y baja latencia que permitan a múltiples chips Ironwood colaborar eficazmente en el entrenamiento de un único modelo gigante o en el manejo de una multitud de solicitudes de inferencia. La capacidad de escalar horizontalmente es tan importante como la potencia individual de un solo chip. Google ha demostrado su experiencia en este campo con las interconexiones de sus TPUs en el pasado, y Ironwood seguramente lleva esto a un nuevo nivel.

Finalmente, la eficiencia energética será un pilar central. Diseñar un chip que sea potente es una cosa, pero diseñar uno que sea potente y eficiente es el verdadero desafío. Esto se logra mediante una combinación de optimizaciones a nivel de microarquitectura, técnicas de gestión de energía inteligentes y, posiblemente, la adopción de procesos de fabricación de semiconductores de última generación (como 3nm o incluso menos). Un chip más eficiente significa menos calor, menos consumo de energía y, en última instancia, centros de datos más sostenibles.

Desde mi perspectiva, la habilidad de Google para controlar el diseño del hardware y del software de IA les da una ventaja competitiva considerable. No solo pueden adaptar el silicio a las necesidades exactas de sus propios marcos de aprendizaje automático (TensorFlow, JAX), sino que también pueden diseñar el software para aprovechar al máximo las peculiaridades arquitectónicas de Ironwood. Esta integración vertical es, sin duda, una de las mayores fortalezas de su estrategia en IA. La optimización específica para tensores es crucial y cada ciclo de mejora de hardware se traduce directamente en un avance exponencial en la capacidad de cálculo para la IA. Se rumorea incluso que Ironwood podría incorporar un diseño modular o flexible, permitiendo adaptar sus capacidades a diferentes cargas de trabajo de IA, desde el entrenamiento intensivo hasta la inferencia en tiempo real con latencias ultrabajas. Esto sería un diferenciador clave en un mercado que demanda versatilidad sin sacrificar la especialización.

Descubre más sobre los chips de Google y su impacto en la IA

Ironwood en el ecosistema de Google

La estrategia de Google con Ironwood no se limita a crear un chip potente; se trata de integrarlo sin fisuras en su vasto y complejo ecosistema, maximizando así su impacto en todos los frentes. La visión de Google siempre ha sido la de democratizar la IA, y Ironwood juega un papel crucial en esta misión, tanto a nivel interno como externo.

Internamente, Ironwood se convertirá, sin duda, en el nuevo caballo de batalla para los servicios de IA de Google que ya utilizamos a diario. Pensemos en la Búsqueda de Google, que cada vez más se apoya en modelos de lenguaje avanzados para comprender consultas complejas y ofrecer respuestas más precisas y contextualmente relevantes. O en Google Assistant, que necesita procesar el lenguaje natural en tiempo real con una latencia mínima. YouTube, con sus recomendaciones personalizadas y la moderación de contenido a escala masiva, también se beneficiaría enormemente de una capacidad de cómputo de IA mejorada. Proyectos ambiciosos como Waymo (conducción autónoma) o DeepMind (investigación fundamental en IA) también demandarán el poder de procesamiento que Ironwood puede ofrecer para sus modelos más sofisticados y hambrientos de datos. La capacidad de ejecutar modelos más grandes y complejos internamente significa que Google puede ofrecer una mejor experiencia de usuario en todos sus productos, desde la traducción instantánea hasta la generación de contenido.

Externamente, el impacto de Ironwood será más evidente a través de Google Cloud. La plataforma en la nube de Google es un proveedor líder de servicios de IA para empresas y desarrolladores de todo el mundo. Con Ironwood, Google Cloud podrá ofrecer a sus clientes un rendimiento sin precedentes para el entrenamiento y la inferencia de modelos de IA. Esto se materializará en servicios como Vertex AI, la plataforma unificada de aprendizaje automático de Google, donde los usuarios podrán acceder a recursos de cómputo de Ironwood para sus propios proyectos. Imaginen el potencial para startups que construyen modelos de IA de próxima generación, o para grandes empresas que buscan optimizar sus cadenas de suministro con IA o desarrollar nuevos fármacos con el apoyo de la inteligencia artificial. La disponibilidad de un hardware tan potente a través de la nube permite a organizaciones de todos los tamaños acceder a capacidades de IA de vanguardia sin la necesidad de invertir en su propia infraestructura costosa.

Explora Google Vertex AI y sus capacidades

Además, Ironwood no solo potenciará los servicios existentes, sino que también permitirá a Google explorar nuevas fronteras en la IA que antes eran inviables debido a limitaciones de hardware. Podríamos ver avances en áreas como la robótica avanzada, la medicina personalizada impulsada por IA, la creación de mundos virtuales más realistas o incluso la solución de problemas científicos complejos a una velocidad y escala nunca antes vistas. La integración de Ironwood en el ecosistema de Google es, en esencia, la pieza que conecta la potencia de procesamiento con las aplicaciones del mundo real, extendiendo el alcance y la utilidad de la inteligencia artificial a todos los rincones donde Google tiene presencia. Esta estrategia de llevar la innovación del chip directamente a los usuarios, ya sea de forma transparente a través de sus productos o explícita a través de sus servicios en la nube, es lo que distingue a Google en la carrera de la IA.

Desafíos y oportunidades para la era de la IA

La introducción de un chip como Ironwood, si bien promete un futuro más brillante para la IA, también nos obliga a reflexionar sobre los desafíos inherentes y las vastas oportunidades que la era de la inteligencia artificial presenta.

Retos en el desarrollo de IA

El primer y más obvio reto es la escalabilidad computacional. A medida que los modelos de IA se vuelven más grandes y sofisticados, la demanda de recursos computacionales crece exponencialmente. Entrenar un modelo de lenguaje de última generación puede costar millones de dólares en tiempo de GPU y consumir tanta energía como una pequeña ciudad. Ironwood busca mitigar este desafío ofreciendo más potencia y eficiencia, pero la carrera armamentista entre la complejidad del modelo y la capacidad del hardware es constante. Este ciclo de mejora continua es, a la vez, una bendición y una carga, ya que exige una inversión masiva en I+D.

Otro desafío significativo es la eficiencia energética. Los centros de datos ya son grandes consumidores de energía, y la adición de más y más chips de IA solo exacerba este problema. Es crucial que los chips como Ironwood no solo sean potentes, sino también líderes en eficiencia para que la IA sea sostenible a largo plazo. La optimización del software y el hardware para reducir el consumo de energía por operación es una prioridad absoluta.

La gestión de datos es el tercer gran reto. Los modelos de IA requieren cantidades masivas de datos para su entrenamiento. No solo se trata de almacenar estos datos, sino de moverlos eficientemente hacia y desde los procesadores, garantizando su calidad, privacidad y seguridad. Un hardware más rápido como Ironwood agrava la necesidad de un rendimiento de E/S (entrada/salida) excepcional y una infraestructura de datos robusta. Los cuellos de botella no siempre están en el procesamiento, sino en la capacidad de alimentar a esos procesadores hambrientos con datos a la velocidad necesaria.

Las promesas de Ironwood

A pesar de estos retos, las oportunidades que Ironwood y chips similares abren son transformadoras. La más evidente es la aceleración de la investigación y el desarrollo. Con un hardware más potente, los investigadores pueden experimentar con nuevas arquitecturas de redes neuronales, entrenar modelos en una fracción del tiempo que antes se requería y explorar hipótesis que antes eran computacionalmente inviables. Esto podría llevar a descubrimientos revolucionarios en áreas como el modelado de proteínas, la creación de materiales avanzados o la comprensión de fenómenos físicos complejos.

La democratización de las capacidades avanzadas de IA es otra promesa. Al hacer que este poder computacional esté disponible a través de la nube, Google permite que un ecosistema mucho más amplio de desarrolladores, startups y empresas acceda a la vanguardia de la IA. Esto significa que la próxima gran innovación en IA no necesariamente provendrá de un gigante tecnológico, sino de cualquier equipo con una idea brillante y acceso a los recursos adecuados. Pienso en cómo esto podría nivelar el campo de juego, empoderando a pequeños equipos para competir con los grandes actores, impulsando así una explosión de creatividad e innovación.

Lee sobre los desafíos computacionales de la IA

Finalmente, Ironwood promete llevar la IA a aplicaciones más sofisticadas y escalables en el mundo real. Imaginen sistemas de atención médica que puedan diagnosticar enfermedades con una precisión sin precedentes en tiempo real, vehículos autónomos que operen con una seguridad aún mayor, o sistemas de energía inteligente que optimicen el consumo a nivel global. El poder de Ironwood no es un fin en sí mismo, sino un medio para construir un futuro donde la IA resuelva algunos de los problemas más apremiantes de la humanidad de maneras que hoy apenas podemos concebir. Es un catalizador para la próxima ola de innovaciones que moldearán nuestras vidas.

Competencia y el futuro del hardware de IA

El lanzamiento de Ironwood por parte de Google se produce en un escenario de intensa competencia por la supremacía en el hardware de inteligencia artificial. No son los únicos actores en este campo, y la carrera por desarrollar el chip definitivo para la IA está en pleno apogeo, con gigantes tecnológicos y startups innovadoras invirtiendo miles de millones.

NVIDIA, con sus GPUs dominantes y su plataforma CUDA, ha sido el líder indiscutible en el entrenamiento de modelos de IA durante años. Sus arquitecturas Hopper y Blackwell son la vara de medir con la que se comparan muchos chips de IA. Sin embargo, su enfoque es más generalista, adaptando GPUs a las necesidades de la IA, mientras que Google, con Ironwood y TPUs, apuesta por una especialización extrema desde el diseño.

Otros actores relevantes incluyen a AMD, que está fortaleciendo su línea de aceleradores de IA con chips como el MI300X, y empresas de semiconductores como Intel, que también buscan su tajada del pastel con proyectos como Gaudi. Además, hay un número creciente de startups, como Cerebras Systems con sus chips masivos de tamaño de oblea o Groq con sus procesadores de lenguaje, que están explorando arquitecturas radicalmente diferentes para la aceleración de IA, a menudo con un enfoque en la inferencia de baja latencia. Incluso otros gigantes tecnológicos como Amazon (con sus chips Trainium e Inferentia) y Microsoft están invirtiendo en sus propios diseños de silicio para optimizar sus operaciones en la nube y el desarrollo de IA.

Análisis de la intensa competencia en el mercado de chips de IA

El futuro del hardware de IA, en mi opinión, será un panorama multifacético y en constante evolución. No creo que un solo chip o una sola arquitectura dominen completamente. En cambio, veremos una mayor especialización: chips optimizados para el entrenamiento masivo, otros para la inferencia de baja latencia en el borde (edge computing), y quizás diseños híbridos que intenten equilibrar ambos. La computación heterogénea, donde diferentes tipos de procesadores (CPUs, GPUs, TPUs, etc.) trabajan en conjunto, también será la norma.

Más allá de la mejora de la arquitectura de silicio, hay áreas de investigación y desarrollo que podrían redefinir completamente el hardware de IA. La fotónica, que utiliza la luz en lugar de la electricidad para transmitir y procesar información, promete velocidades inimaginables y una eficiencia energética sin precedentes. Los pro